Pengikisan web mungkin terlihat sederhana tetapi sebenarnya bisa menjadi upaya yang agak rumit. Banyak pemilik situs web mencoba untuk secara aktif melindunginya untuk melindungi data mereka yang sebagian besar menghalangi menjalankan skrip internal untuk berulang kali menarik data dari situs web target. Untuk pengikisan yang efisien, yang Anda butuhkan adalah alat khusus seperti Scrapestack API yang akan kami ulas . Dengan menggunakannya, Anda dapat dengan cepat dan efisien mengikis hampir semua situs web dan mengekstrak informasi yang dikandungnya dan memanfaatkannya dengan baik. Scrapestack menyediakan cara menggores situs web yang cepat dan mudah digunakan dan sangat skalabel.

Sebelum kita membahas lebih detail tentang Scrapestack API , kita akan mulai dengan membahas scraping. Kami akan menjelaskan apa itu dan mengapa itu digunakan secara luas di seluruh Internet. Dan berbicara tentang Internet, kita kemudian akan melihat kasus spesifik dari web scraping karena untuk itulah Scrapestack API dibuat dan kami juga akan memperkenalkan beberapa alasan terpenting mengapa orang akan menggunakan pihak ketiga menggores API seperti ini. Setelah menjelaskan secara singkat apa itu REST API, akhirnya kita akan masuk ke inti permasalahan saat kita menyajikan Scrapestack API. Pertama-tama kami akan memiliki gambaran umum produk sebelum kami menganalisis lebih lanjut beberapa fitur terbaiknya. Kami akan mengikuti dengan melihat betapa mudahnya menggunakan API sebelum kami menyajikan struktur harga multi-tingkat layanan.

Menggores Singkatnya

Pengikisan data adalah proses mengekstraksi data dari keluaran yang dapat dibaca manusia yang berasal dari program atau proses lain. Ini berbeda dari bentuk transfer data lainnya dalam beberapa cara. Transfer data antar program biasanya dilakukan dengan menggunakan struktur data yang cocok untuk pemrosesan otomatis oleh komputer. Format dan protokol pertukaran ini terstruktur secara kaku, terdokumentasi dengan baik, mudah diuraikan, dan meminimalkan ambiguitas. Transmisi ini biasanya tidak dapat dibaca manusia sama sekali. Mereka dirancang untuk menjadi efisien dan cepat. Elemen utama yang membedakan pengikisan data dari bentuk lain dari pertukaran data adalah bahwa output yang sedang dikerok biasanya dimaksudkan untuk ditampilkan kepada pengguna akhir, bukan sebagai masukan untuk program lain. Oleh karena itu, jarang didokumentasikan atau terstruktur untuk penguraian yang nyaman.

There are a few reasons why one would resort to data scraping. For instance, it is most often done either to interface to a legacy system, one which has no other mechanism that is compatible with current transfer mechanisms. It could also be used to pull data from a third-party system which does not provide a more convenient API. In this latter case, the owner of the third-party system can see data scraping as unwanted due to reasons such as increased system load, the loss of advertisement revenue, or the loss of control of the information content.

Sejauh ini, pengikisan data biasanya dianggap sebagai teknik ad hoc, tidak elegan yang sering digunakan sebagai upaya terakhir ketika tidak ada mekanisme lain untuk pertukaran data yang tersedia. Pengikisan data sering dikaitkan dengan pemrograman dan pemrosesan overhead yang lebih tinggi karena tampilan output yang ditujukan untuk konsumsi manusia sering sering mengubah struktur. Sementara manusia dapat dengan mudah beradaptasi dengan perubahan ini, program komputer mungkin tidak, karena disuruh membaca data dalam format tertentu atau dari lokasi tertentu tanpa pengetahuan tentang cara memeriksa validitas hasilnya.

Kasus Spesifik Pengikisan Web

Pengikisan web hanyalah jenis pengikisan data tertentu yang digunakan untuk mengambil data dari halaman web. Halaman web, seperti yang Anda ketahui, dibuat menggunakan bahasa mark-up berbasis teks seperti HTML dan XHTML. Namun, mereka biasanya dirancang untuk pengguna akhir manusia dan bukan untuk kemudahan penggunaan otomatis. Ini adalah alasan utama mengapa scraper web seperti Scrapestack API dibuat. Scraper web adalah API atau alat yang mengekstrak data dari situs web.

Karena organisasi cenderung sangat protektif terhadap data mereka, situs web besar biasanya menggunakan algoritme defensif untuk melindunginya dari pengikis web. Mereka dapat, misalnya, membatasi jumlah permintaan yang dapat dikirim oleh IP atau jaringan IP. Alat pengikisan web terbaik menyertakan mekanisme untuk melawan perlindungan ini.

Menggunakan API Scraping Pihak Ketiga

Pengikisan web dari halaman web sederhana dan statis cenderung lebih mudah diterapkan. Sayangnya, halaman web yang sederhana dan statis adalah sesuatu dari masa lalu dan sebagian besar situs web modern menggunakan berbagai teknologi untuk menyediakan konten dinamis kepada pengunjungnya. Di sinilah menggunakan alat pihak ketiga dapat menjadi menguntungkan. Alat-alat ini akan menangani semua detail yang mendasarinya dan muncul ke situs web yang mereka coba gores sebagai pengguna biasa. Beberapa bahkan akan pergi sejauh mengisi formulir untuk Anda. Tetapi alasan terbaik mengapa siapa pun akan menggunakan alat pengikis pihak ketiga seperti Scrapestack API adalah kenyamanan. Menggunakannya hanya membuat segalanya lebih mudah.

Apa itu REST API?

API, yang merupakan singkatan dari antarmuka pemrograman aplikasi, adalah sarana untuk memanggil satu program atau proses dari yang lain. Selanjutnya, proses yang dipanggil bahkan tidak harus berjalan pada perangkat yang sama dengan yang dipanggil. Adapun bagian REST, ini sedikit lebih rumit. Mari kita coba jelaskan.

REST, yang merupakan singkatan dari REpresentational State Transfer, adalah gaya arsitektur perangkat lunak yang menguraikan serangkaian batasan yang akan digunakan untuk membuat layanan web. Mereka yang sesuai dengan gaya arsitektur REST disebut layanan web RESTful dan mereka menawarkan interoperabilitas antara sistem komputer di Internet. Selain itu, mereka mengizinkan sistem yang meminta untuk mengakses dan memanipulasi representasi tekstual dari berbagai sumber daya web dengan menggunakan serangkaian operasi stateless yang seragam dan telah ditentukan sebelumnya.

Dalam istilah yang lebih sederhana, REST API adalah salah satu yang dapat dengan mudah diakses menggunakan panggilan web standar seperti HTTP “get”, “post”, “put”, dan “delete” dan yang mengembalikan data yang diminta secara terorganisir. Dalam kasus khusus dari Scrapestack API , ia menggunakan format JSON yang populer. Oleh karena itu, hasil dapat dengan mudah diproses menggunakan bahasa umum seperti Javascript. Alat lain dapat menggunakan format lain—dengan XML menjadi sangat populer. Spesifikasi REST hanya mengamanatkan bahwa format tetap yang telah ditentukan digunakan.

Memperkenalkan Scrapestack API

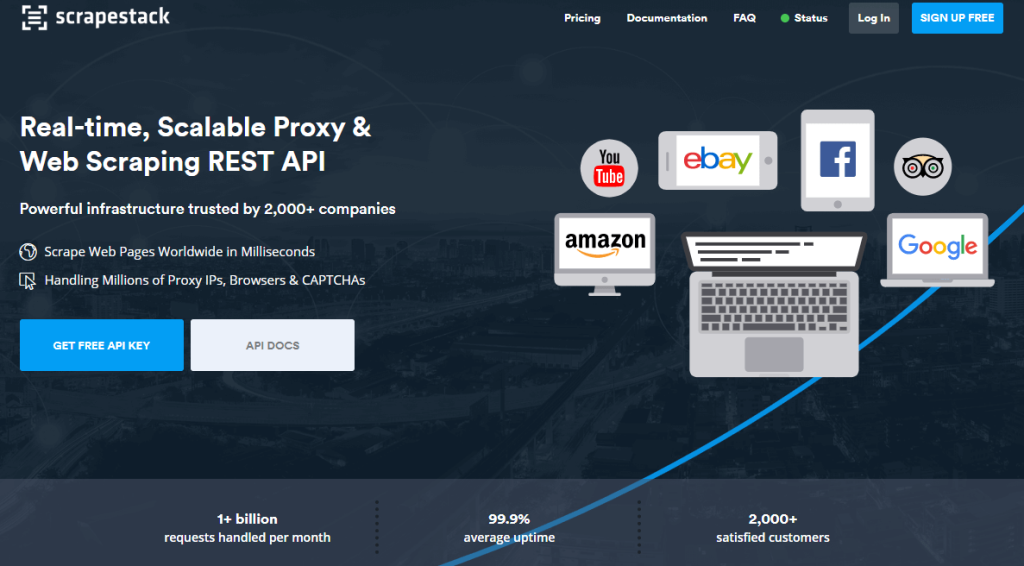

The Scrapestack API adalah, Anda harus telah menemukan jawabannya, API REST untuk Scraping web. Singkatnya, Scrapestack API dapat mengubah halaman web apa pun menjadi data yang dapat ditindaklanjuti. Ini adalah layanan API berbasis cloud yang memungkinkan penggunanya untuk mengikis situs web tanpa harus khawatir tentang masalah teknis seperti proxy, blok IP, penargetan geografis, pemecahan CAPTCHA, dan banyak lagi. Untuk menggunakannya, Anda cukup memberikan URL situs web yang valid dan, hanya dalam beberapa milidetik, Scrapestack API akan mengembalikan konten HTML lengkap situs sebagai tanggapan. Konten yang Anda dapatkan akan muncul seperti yang terlihat di browser, termasuk rendering JavaScript apa pun daripada kode sebenarnya yang merupakan bagian dari halaman web. Alat ini didukung oleh salah satu mesin pengikis web paling kuat di pasaran dan menawarkan salah satu solusi terbaik untuk semua kebutuhan pengikisan Anda.

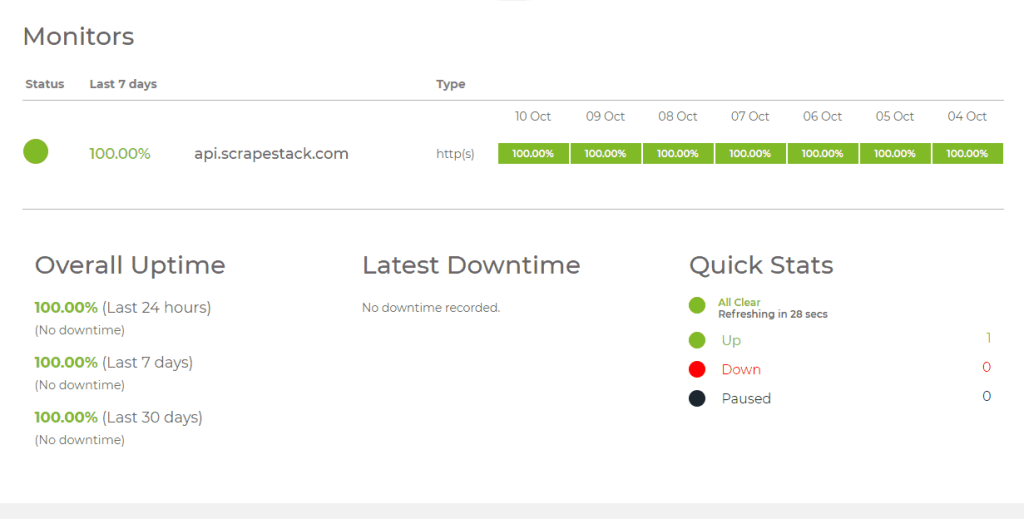

The Scrapestack API dikembangkan dan dikelola oleh apilayer , sebuah perusahaan perangkat lunak yang berbasis di London, Inggris dan Wina, Austria. Ini adalah perusahaan yang sama yang berada di balik beberapa produk API dan SaaS populer di seluruh dunia, termasuk weatherstack, invoice, dan eversign. Infrastruktur yang kuat ini digunakan oleh lebih dari 2000 organisasi di seluruh dunia. Saat ini, layanan online, yang dibuat untuk memproses jutaan alamat IP proxy, browser, dan CAPTCHA, menangani lebih dari satu miliar permintaan setiap bulan dan menawarkan waktu aktif rata-rata 99,9% yang mengesankan. Ini memastikan bahwa layanan akan tersedia saat Anda membutuhkannya.

Tur Fitur Utama Scrapestack API

Dari segi fitur, Scrapestack API tidak meninggalkan banyak hal yang diinginkan tidak peduli mengapa Anda perlu mengikis situs web atau data apa yang Anda coba dapatkan, produk tersebut kemungkinan besar sangat sesuai dengan kebutuhan Anda. Mari kita jelajahi secara singkat beberapa fitur terpenting dari alat ini.

Jutaan Proxy Dan Alamat IP

Salah satu cara situs web menjaga agar tidak tergores adalah dengan mengidentifikasi alamat IP sumber yang menghasilkan banyak permintaan yang berurutan. Untuk alasan itu, alat pengikisan web harus menggunakan alamat IP yang berbeda untuk setiap permintaan. The Scrapestack API alamat ini dengan menawarkan sebuah kolam renang yang luas dari pusat lebih 35.000.000 data dan alamat IP proxy perumahan yang tersebar di puluhan penyedia layanan internet global serta dengan mendukung perangkat nyata, retries cerdas dan rotasi IP. Ini memastikan bahwa permintaan pengikisan Anda kemungkinan besar tidak akan diperhatikan ke situs yang sedang dikikis.

Pusat data atau proxy "standar" adalah yang paling umum. Mereka tidak dimiliki oleh ISP tertentu dan mereka hanya menutupi alamat IP asal Anda dengan menunjukkan alamat IP sumber proxy pusat data dan informasi yang terkait dengan perusahaan yang memiliki pusat data masing-masing.

Adapun proxy perumahan atau "premium", mereka memberikan alamat IP yang terhubung ke alamat perumahan nyata dan perangkat rumah. Ini membuat mereka jauh lebih kecil kemungkinannya untuk diblokir saat mengikis web. Menggunakan proxy residensial untuk web scraping memudahkan untuk mengatasi konten yang diblokir secara geografis dan mengumpulkan data dalam jumlah besar.

Lebih dari Seratus Lokasi Global

Beberapa situs web akan mengembalikan informasi yang berbeda berdasarkan lokasi asal permintaan. Demikian juga, beberapa situs hanya akan menerima permintaan dari lokasi tertentu. Salah satu contohnya adalah situs web seperti Netflix yang hanya akan menerima koneksi masuk lokal. Netflix AS hanya dapat diakses dari alamat IP yang berbasis di AS dan Netflix Kanada hanya dapat diakses dari alamat IP Kanada. The Scrapestack API dapat membiarkan Anda memilih dari lebih dari seratus lokasi global yang didukung untuk mengirim web Scraping permintaan API Anda. Anda juga memiliki opsi untuk menggunakan target geografis acak, mendukung serangkaian kota besar di seluruh dunia.

Infrastruktur Rock-Solid

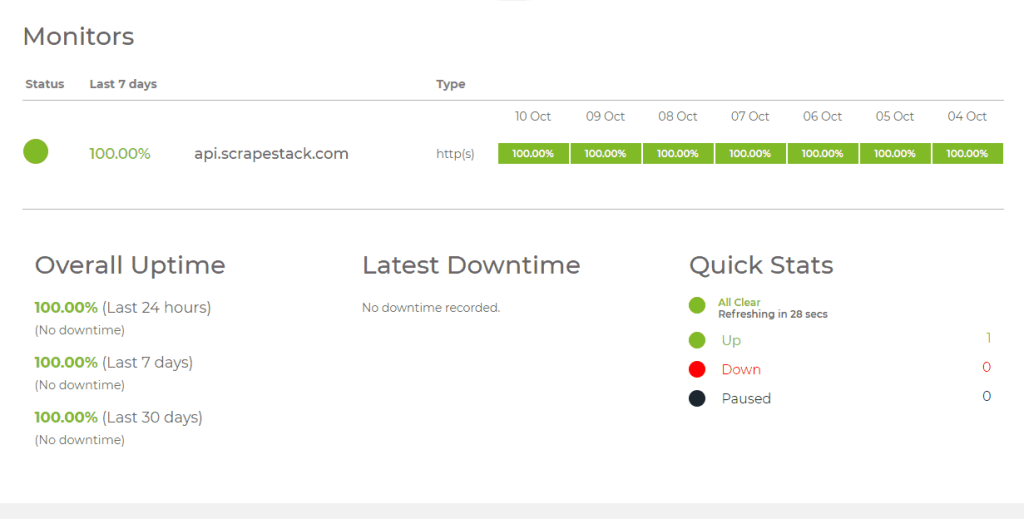

Layanan berbasis cloud seperti Scrapestack API hanya sebaik infrastruktur yang dibangunnya. Untuk itu, ini adalah layanan yang kokoh dengan waktu aktif yang mengesankan. Menggunakan layanan ini memungkinkan Anda mengikis web dengan kecepatan yang tak tertandingi. Anda juga akan mendapat manfaat dari sekumpulan fitur lanjutan seperti permintaan API bersamaan, pemecahan CAPTCHA, dukungan browser, dan rendering JS. Layanan ini dibangun di atas infrastruktur cloud apilayer . Hal ini membuat layanan sangat skalabel dan mampu menangani apa pun, mulai dari hanya ribuan permintaan API per bulan hingga jutaan per hari. Ini didukung oleh sistem yang meningkatkan dan menurunkan skala sesuai kebutuhan dan dapat memberikan waktu respons setinggi mungkin untuk permintaan API apa pun di tingkat pemanfaatan apa pun.

Menggunakan API Scrapestack

Menggunakan Scrapestack API semudah mungkin. Langkah pertama tentu saja membuat akun. Membuatnya akan mengungkapkan kunci akses API unik Anda yang harus Anda gunakan dengan setiap permintaan untuk mengautentikasi dengan API. Anda melakukannya hanya dengan menambahkan parameter access_key ke URL dasar API dan menyetelnya ke kunci akses API Anda.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY

Paket berbayar mendukung enkripsi HTTPS 256-bit. Untuk menggunakannya, yang perlu Anda lakukan hanyalah menggunakan HTTPS alih-alih HTTP dalam panggilan API Anda.

Jenis permintaan yang paling dasar secara tepat disebut sebagai permintaan "dasar". Dalam bentuknya yang paling dasar, Anda hanya perlu menentukan kunci akses API dan URL halaman yang ingin Anda coret. Misalnya, untuk mengikis halaman https://apple.com, permintaan akan terlihat seperti ini:

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com

Perhatikan bahwa ada beberapa parameter opsional yang dapat ditambahkan ke permintaan Anda. Kami akan membahas beberapa di antaranya secara lebih rinci dalam beberapa saat.

Setelah eksekusi berhasil, API merespons dengan data HTML mentah dari URL halaman web target Anda. Seperti inilah respons tipikal dari permintaan dasar. Perhatikan bahwa itu telah dipersingkat untuk tujuan keterbacaan. Respons aktual akan mencakup semua kode di dalam

dan

bagian.

[...] // 44 baris dilewati [...] // 394 baris dilewati

Parameter Opsional

Parameter opsional pertama dan paling sering digunakan tentu saja Rendering JavaScript . Ini tersedia di semua paket berbayar. Seperti yang Anda ketahui, beberapa halaman web merender elemen halaman penting menggunakan JavaScript. Ini berarti bahwa beberapa konten tidak ada—dan karenanya tidak dapat dihapus—dengan pemuatan halaman awal. Dengan mengaktifkan parameter render_js, Scrapestack API akan mengakses web target menggunakan browser tanpa kepala (Google Chrome) dan memungkinkan elemen halaman JavaScript untuk dirender sebelum memberikan hasil pengikisan akhir. Mengaktifkan opsi ini adalah masalah sederhana dengan menambahkan parameter render_js ke URL permintaan API Anda dan menyetelnya ke 1.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://Apple.com & render_js = 1

Parameter opsional lain yang berguna adalah kemampuan untuk menentukan Lokasi Proksi , juga tersedia di semua paket berbayar. The Scrapestack API menggunakan kolam lebih dari 35 juta alamat IP di seluruh dunia. Secara default, secara otomatis akan memutar alamat IP sedemikian rupa sehingga alamat IP yang sama tidak pernah digunakan dua kali berturut-turut. Menggunakan parameter opsional proxy_location API, Anda dapat memilih negara tertentu dengan menunjukkan kode negara 2 hurufnya. Misalnya, contoh di bawah ini menetapkan au (Australia) sebagai lokasi proxy. Kueri dengan demikian akan dijalankan dari alamat IP yang berbasis di Australia.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & proxy_location = au

The Premium Proxy adalah pilihan lain yang menarik. Berikut cara kerjanya. Secara default, Scrapestack API selalu menggunakan proxy standar (pusat data) untuk permintaan scraping. Dan meskipun mereka adalah proxy yang paling umum digunakan di internet, mereka juga lebih mungkin untuk diblokir ketika mencoba untuk mengikis data.

Jika Anda berlangganan Paket Profesional atau lebih tinggi, Scrapestack API memungkinkan akses ke proxy premium (perumahan). Itu terkait dengan alamat tempat tinggal yang sebenarnya dan karena itu kecil kemungkinannya untuk diblokir saat menggores data di web. Seperti parameter opsional lainnya, menggunakan opsi ini hanyalah masalah menambahkan parameter premium_proxy ke permintaan pengikisan Anda dan menyetelnya ke 1.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & premium_proxy = 1

Meskipun kami dapat melanjutkan cukup lama untuk membahas banyak opsi yang tersedia dengan Scrapestack API , tujuan kami adalah meninjau produk, bukan menulis manual untuknya. Selain itu, situs web Scrapestack memiliki dokumentasi yang sangat lengkap dan harus menjadi sumber utama Anda tentang informasi petunjuk .

Informasi Harga

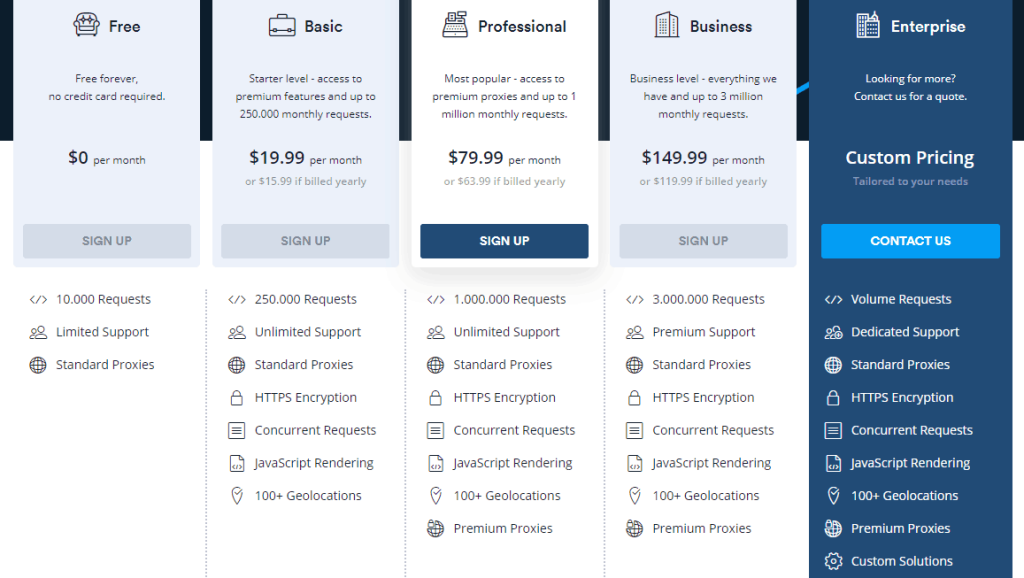

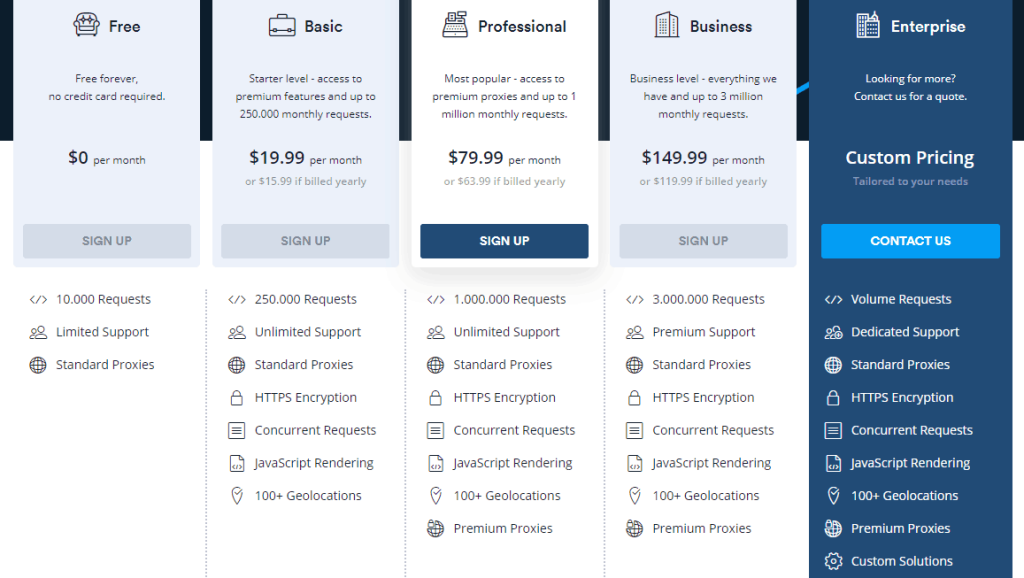

Layanan Scrapestack API tersedia dalam beberapa paket harga. Pada tingkat terendah, Paket Gratis menawarkan cara untuk mengenal API. Ini memiliki fungsionalitas API dasar dan batasan 10.000 permintaan API per bulan. Jika Anda perlu menjalankan lebih banyak kueri atau memerlukan serangkaian fitur yang lebih canggih, seperti permintaan bersamaan atau akses proxy premium, Anda dapat memilih dari salah satu paket berbayar yang tersedia.

Dengan sebagian besar paket berbayar yang menawarkan rangkaian fitur serupa, faktor penentu dalam hal persyaratan teknis Anda sering kali adalah jumlah permintaan API yang perlu Anda buat setiap bulan. Pembayaran dapat dilakukan dengan kartu kredit atau PayPal. Selanjutnya, pelanggan perusahaan dan pelanggan bervolume tinggi dapat meminta pembayaran transfer bank tahunan diaktifkan. Dan berbicara tentang pembayaran tahunan, memilih opsi ini memberi Anda diskon 20% dibandingkan dengan pembayaran bulanan, membuat produk lebih terjangkau. Dan jika Anda tidak yakin tentang frekuensi penagihan, perhatikan bahwa Anda dapat (relatif) dengan mudah beralih dari bulanan ke tahunan dan sebaliknya. Namun, ini melibatkan penurunan versi pertama ke paket gratis dan segera meningkatkan ke paket berbayar.

Intinya

No matter how simple or how complex your web scraping need may be, the Scrapestack API can most likely help you reach your goals simply and effortlessly. With impressive reliability and scalabilty. This cloud-based service will flawlessly adapt to almost any situation. It has all the options one might need and it offers the means to spoof your scraping attempts behind millions of proxied IP addresses.

Still not sure whether the Scrapestack API is right for you? Why don’t you take advantage of the available free plan and give the service a trial run. I’m pretty sure you’ll be just amazed as I am by its overall usefulness and performance.