Setiap Pembetulan untuk Ralat ERR_TUNNEL_CONNECTION_FAILED

Betulkan ralat ERR_TUNNEL_CONNECTION_FAILED dalam Chrome dengan penyelesaian terbukti ini. Ketahui punca dan cara menyelesaikannya dengan cepat.

Mengikis web mungkin kelihatan mudah tetapi ia sebenarnya boleh menjadi usaha yang agak rumit. Ramai pemilik tapak web cuba melindungi secara aktif daripadanya untuk melindungi data mereka yang kebanyakannya menghalang menjalankan skrip dalaman untuk menarik data berulang kali daripada tapak web sasaran. Untuk pengikisan yang cekap, apa yang anda perlukan ialah alat khusus seperti API Scrapestack yang akan kami semak. Menggunakannya, anda boleh mengikis hampir mana-mana tapak web dengan cepat dan cekap dan mengekstrak maklumat yang terkandung di dalamnya dan menggunakannya dengan baik. Scrapestack menyediakan cara yang cepat dan mudah digunakan serta sangat berskala untuk mengikis tapak web.

Sebelum kita pergi ke lebih terperinci tentang Scrapestack API , kita akan mulakan dengan membincangkan mengikis. Kami akan menerangkan apa itu dan mengapa ia digunakan secara meluas di seluruh Internet. Dan bercakap tentang Internet, kami kemudian akan melihat kes khusus pengikisan web kerana ini adalah tujuan API Scrapestack dibuat dan kami juga akan memperkenalkan beberapa sebab paling penting mengapa sesiapa sahaja akan menggunakan pihak ketiga mengikis API seperti ini. Selepas menerangkan secara ringkas apa itu API REST, akhirnya kami akan sampai ke inti perkara itu semasa kami membentangkan API Scrapestack. Kami terlebih dahulu akan mempunyai gambaran keseluruhan produk sebelum kami menganalisis lebih lanjut beberapa ciri terbaiknya. Kami akan mengikuti dengan melihat betapa mudahnya menggunakan API sebelum kami membentangkan struktur harga berbilang peringkat perkhidmatan.

Mengikis Secara Ringkasnya

Pengikisan data ialah proses mengekstrak data daripada output yang boleh dibaca manusia yang datang daripada program atau proses lain. Ia berbeza daripada bentuk pemindahan data lain dalam beberapa cara. Pemindahan data antara program biasanya dilakukan menggunakan struktur data yang sesuai untuk pemprosesan automatik oleh komputer. Format dan protokol pertukaran ini berstruktur tegar, didokumentasikan dengan baik, mudah dihuraikan dan mengekalkan kesamaran pada tahap minimum. Penghantaran ini biasanya tidak boleh dibaca oleh manusia sama sekali. Mereka direka untuk menjadi cekap dan pantas. Elemen utama yang membezakan pengikisan data daripada bentuk pertukaran data yang lain ialah output yang dikikis biasanya bertujuan untuk paparan kepada pengguna akhir, bukannya sebagai input kepada program lain. Oleh itu, ia jarang didokumenkan atau distrukturkan untuk penghuraian yang mudah.

Terdapat beberapa sebab mengapa seseorang akan menggunakan pengikisan data. Sebagai contoh, ia paling kerap dilakukan sama ada untuk antara muka kepada sistem warisan, yang tidak mempunyai mekanisme lain yang serasi dengan mekanisme pemindahan semasa. Ia juga boleh digunakan untuk menarik data daripada sistem pihak ketiga yang tidak menyediakan API yang lebih mudah. Dalam kes terakhir ini, pemilik sistem pihak ketiga boleh melihat pengikisan data sebagai tidak diingini disebabkan oleh sebab seperti peningkatan beban sistem, kehilangan hasil iklan atau kehilangan kawalan kandungan maklumat.

Walaupun semakin meluas, pengikisan data biasanya dianggap sebagai teknik ad hoc, tidak elegan yang sering digunakan sebagai pilihan terakhir apabila tiada mekanisme lain untuk pertukaran data tersedia. Pengikisan data sering dikaitkan dengan overhed pengaturcaraan dan pemprosesan yang lebih tinggi kerana paparan output yang bertujuan untuk kegunaan manusia sering menukar struktur dengan kerap. Walaupun manusia mudah menyesuaikan diri dengan perubahan ini, program komputer mungkin tidak, setelah diberitahu untuk membaca data dalam format tertentu atau dari lokasi tertentu tanpa pengetahuan tentang cara menyemak keputusan untuk kesahihan.

Kes Khusus Mengikis Web

Pengikisan web hanyalah jenis pengikisan data khusus yang digunakan untuk mengambil data daripada halaman web. Halaman web, seperti yang anda tahu, dibina menggunakan bahasa mark-up berasaskan teks seperti HTML dan XHTML. Walau bagaimanapun, ia biasanya direka untuk pengguna akhir manusia dan bukan untuk kemudahan penggunaan automatik. Inilah sebab utama mengapa pengikis web seperti API Scrapestack dicipta. Pengikis web ialah API atau alat yang mengekstrak data daripada tapak web.

Memandangkan organisasi cenderung sangat melindungi data mereka, tapak web utama biasanya menggunakan algoritma pertahanan untuk melindunginya daripada pengikis web. Mereka boleh, sebagai contoh, mengehadkan bilangan permintaan yang boleh dihantar oleh rangkaian IP atau IP. Alat mengikis web terbaik termasuk mekanisme untuk mengatasi perlindungan ini.

Menggunakan API Pengikisan Pihak Ketiga

Mengikis web dari halaman web yang ringkas dan statik cenderung agak mudah untuk dilaksanakan. Malangnya, laman web yang ringkas dan statik adalah perkara yang sudah lama berlalu dan kebanyakan tapak web moden menggunakan pelbagai teknologi untuk menyediakan kandungan dinamik kepada pelawat mereka. Di sinilah menggunakan alat pihak ketiga boleh menjadi berfaedah. Alat ini akan mengendalikan semua perincian asas dan muncul di tapak web yang cuba dikikis sebagai pengguna biasa. Ada juga yang akan pergi setakat mengisi borang untuk anda. Tetapi sebab terbaik mengapa sesiapa sahaja akan menggunakan alat mengikis pihak ketiga seperti API Scrapestack adalah kemudahan. Menggunakannya hanya menjadikan perkara lebih mudah.

Apakah API REST?

API, yang bermaksud antara muka pengaturcaraan aplikasi, ialah satu cara untuk memanggil satu program atau proses daripada yang lain. Tambahan pula, proses yang dipanggil tidak perlu dijalankan pada peranti yang sama dengan penerima. Bagi bahagian REST, ia sedikit lebih rumit. Cuba kita terangkan.

REST, yang bermaksud Pemindahan Negeri Perwakilan, ialah gaya seni bina perisian yang menggariskan satu set kekangan untuk digunakan untuk membuat perkhidmatan web. Mereka yang mematuhi gaya seni bina REST dipanggil perkhidmatan web RESTful dan mereka menawarkan kebolehoperasian antara sistem komputer di Internet. Tambahan pula, mereka membenarkan sistem yang meminta untuk mengakses dan memanipulasi perwakilan teks pelbagai sumber web dengan menggunakan set operasi tanpa kewarganegaraan yang seragam dan pratakrif.

Dalam istilah yang lebih mudah, REST API ialah API yang boleh diakses dengan mudah menggunakan panggilan web standard seperti HTTP "get", "post", "put" dan "delete" dan yang mengembalikan data yang diminta dalam cara yang teratur. Dalam kes khusus API Scrapestack , ia menggunakan format JSON yang popular. Oleh itu, keputusan boleh diproses dengan mudah menggunakan bahasa biasa seperti Javascript. Alat lain boleh menggunakan format lain—dengan XML sangat popular. Spesifikasi REST hanya memberi mandat bahawa format tetap dan pratakrif digunakan.

Memperkenalkan The Scrapestack API

The Scrapestack API adalah, anda mesti telah digambarkan ia keluar, API REST untuk mengikis web. Secara ringkasnya, Scrapestack API boleh menukar mana-mana halaman web menjadi data yang boleh diambil tindakan. Ia ialah perkhidmatan API berasaskan awan yang membolehkan penggunanya mengikis tapak web tanpa perlu risau tentang isu teknikal seperti proksi, blok IP, penyasaran geo, penyelesaian CAPTCHA dan banyak lagi. Untuk menggunakannya, anda hanya memberikan URL tapak web yang sah dan, dalam masa beberapa milisaat sahaja, API Scrapestack akan mengembalikan kandungan HTML penuh tapak sebagai respons. Kandungan yang anda perolehi akan muncul seperti yang dilihat dalam penyemak imbas, termasuk sebarang pemaparan JavaScript dan bukannya kod sebenar yang merupakan sebahagian daripada halaman web. Alat ini dikuasakan oleh salah satu enjin pengikis web yang paling berkuasa di pasaran dan ia menawarkan salah satu penyelesaian terbaik untuk semua keperluan mengikis anda.

The Scrapestack API dibangunkan dan diselenggarakan oleh apilayer , sebuah syarikat perisian berpangkalan di London, UK dan Vienna, Austria. Ia adalah syarikat yang sama yang berada di belakang beberapa produk API dan SaaS yang popular di seluruh dunia, termasuk timbunan cuaca, invois dan eversign. Infrastruktur berkuasa ini digunakan oleh lebih daripada 2000 organisasi di seluruh dunia. Pada masa ini, perkhidmatan dalam talian, yang dibina untuk memproses berjuta-juta alamat IP proksi, penyemak imbas dan CAPTCHA, mengendalikan lebih satu bilion permintaan setiap bulan dan ia mempunyai purata masa operasi 99.9% yang mengagumkan. Ini memastikan bahawa perkhidmatan akan tersedia apabila anda memerlukannya.

Jelajah Ciri-ciri Utama Scrapestack API

Dari segi ciri, API Scrapestack tidak meninggalkan banyak perkara yang diingini tidak kira mengapa anda perlu mengikis tapak web atau data yang anda cuba dapatkan, produk itu berkemungkinan besar sesuai untuk keperluan anda. Mari kita terokai secara ringkas beberapa ciri terpenting alat ini.

Berjuta-juta Proksi Dan Alamat IP

Salah satu cara tapak web menjaga daripada mengikis adalah dengan mengenal pasti alamat IP sumber yang menjana berbilang permintaan berturut-turut. Atas sebab itu, alat mengikis web mesti menggunakan alamat IP yang berbeza untuk setiap permintaan. The Scrapestack API alamat ini dengan menawarkan kolam renang yang luas pusat lebih 35.000.000 data dan kediaman alamat IP diproksikan tersebar di berpuluh-puluh penyedia perkhidmatan internet global serta dengan menyokong peranti sebenar, cubaan semula pintar dan putaran IP. Ini memastikan bahawa permintaan mengikis anda kemungkinan besar tidak akan disedari ke tapak yang sedang dikikis.

Pusat data atau proksi "standard" adalah yang paling biasa. Mereka tidak dimiliki oleh mana-mana ISP tertentu dan mereka hanya menutup alamat IP asal anda dengan menunjukkan alamat IP sumber proksi pusat data dan maklumat yang dikaitkan dengan syarikat yang memiliki pusat data masing-masing.

Bagi proksi kediaman atau "premium", mereka menyediakan alamat IP yang disambungkan ke alamat kediaman dan peranti rumah sebenar. Ini menjadikan mereka kurang berkemungkinan disekat semasa mengikis web. Menggunakan proksi kediaman untuk mengikis web memudahkan untuk menangani kandungan yang disekat geo dan menuai sejumlah besar data.

Lebih Seratus Lokasi Global

Sesetengah tapak web akan mengembalikan maklumat yang berbeza berdasarkan lokasi permintaan itu datang. Begitu juga, sesetengah tapak hanya akan menerima permintaan dari lokasi tertentu. Satu contoh sedemikian ialah tapak web seperti Netflix yang hanya akan menerima sambungan masuk tempatan. Netflix AS hanya boleh diakses daripada alamat IP yang berpangkalan di AS dan Netflix Kanada hanya boleh diakses daripada alamat IP Kanada. The Scrapestack API boleh membiarkan anda memilih daripada lebih seratus lokasi global disokong untuk menghantar web mengikis permintaan API anda. Anda juga mempunyai pilihan untuk menggunakan sasaran geo rawak, menyokong siri bandar utama di seluruh dunia.

Infrastruktur Rock-Solid

Perkhidmatan berasaskan awan seperti Scrapestack API hanya sebaik infrastruktur yang dibina di atasnya. Untuk kesan itu, ini adalah perkhidmatan yang mantap dengan masa operasi yang mengagumkan. Menggunakan perkhidmatan ini membolehkan anda mengikis web pada kelajuan yang tiada tandingan. Anda juga akan mendapat manfaat daripada rangkaian ciri lanjutan seperti permintaan API serentak, penyelesaian CAPTCHA, sokongan penyemak imbas dan pemaparan JS. Perkhidmatan ini dibina di atas infrastruktur awan apilayer . Ini menjadikan perkhidmatan sangat berskala dan mampu mengendalikan apa sahaja daripada hanya beribu-ribu permintaan API setiap bulan sehingga berjuta-juta sehari. Ia dikuasakan oleh sistem yang meningkatkan dan menurunkan skala mengikut keperluan dan ia boleh memberikan masa tindak balas setinggi mungkin untuk sebarang permintaan API pada sebarang tahap penggunaan.

Menggunakan The Scrapestack API

Menggunakan API Scrapestack adalah semudah yang boleh. Langkah pertama, sudah tentu, adalah untuk membuat akaun. Menciptanya akan mendedahkan kunci akses API unik anda yang anda mesti gunakan dengan setiap permintaan untuk mengesahkan dengan API. Anda melakukannya dengan hanya menambahkan parameter access_key pada URL asas API dan menetapkannya pada kunci akses API anda.

https://api.screpestack.com/scrape ? access_key = YOUR_ACCESS_KEY

Pelan berbayar menyokong penyulitan HTTPS 256-bit. Untuk menggunakannya, anda hanya perlu menggunakan HTTPS dan bukannya HTTP dalam panggilan API anda.

Jenis permintaan yang paling asas sesuai dirujuk sebagai permintaan "asas". Dalam bentuk paling asasnya, anda hanya perlu menentukan kunci akses API anda dan URL halaman yang anda mahu dikikis. Sebagai contoh, untuk mengikis halaman https://apple.com, permintaan akan kelihatan seperti ini:

https://api.screpestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com

Ambil perhatian bahawa terdapat beberapa parameter pilihan yang boleh ditambahkan pada permintaan anda. Kami akan membincangkan beberapa perkara ini dengan lebih terperinci sebentar lagi.

Selepas pelaksanaan berjaya, API bertindak balas dengan data HTML mentah URL halaman web sasaran anda. Begini rupa tindak balas biasa daripada permintaan asas. Ambil perhatian bahawa ia telah dipendekkan untuk tujuan kebolehbacaan. Respons sebenar akan merangkumi semua kod dalam

dan

bahagian.

[...] // 44 baris dilangkau [...] // 394 baris dilangkau

Parameter Pilihan

Parameter pilihan yang pertama dan paling banyak digunakan ialah Rendering JavaScript . Ia tersedia pada semua pelan berbayar. Seperti yang anda ketahui, sesetengah halaman web memaparkan elemen halaman penting menggunakan JavaScript. Ini bermakna bahawa sesetengah kandungan tidak hadir—dan oleh itu tidak boleh dikikis—dengan pemuatan halaman awal. Dengan parameter render_js didayakan, API Scrapestack akan mengakses web sasaran menggunakan penyemak imbas tanpa kepala (Google Chrome) dan membenarkan elemen halaman JavaScript untuk dipaparkan sebelum menyampaikan hasil pengikisan akhir. Mendayakan pilihan ini ialah perkara mudah untuk menambahkan parameter render_js pada URL permintaan API anda dan menetapkannya kepada 1.

https://api.screpestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & render_js = 1

Parameter pilihan lain yang berguna ialah keupayaan untuk menentukan Lokasi Proksi , juga tersedia pada semua pelan berbayar. The Scrapestack API menggunakan sekumpulan lebih 35 juta alamat IP di seluruh dunia. Secara lalai, ia akan memutarkan alamat IP secara automatik dengan cara alamat IP yang sama tidak pernah digunakan dua kali berturut-turut. Menggunakan parameter pilihan lokasi_proksi API, anda boleh memilih negara tertentu dengan menunjukkan kod negara 2 hurufnya. Sebagai contoh, contoh di bawah menentukan au (Australia) sebagai lokasi proksi. Oleh itu, pertanyaan akan dijalankan daripada alamat IP yang berpangkalan di Australia.

https://api.screpestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & proxy_location = au

The Premium Proksi adalah satu lagi pilihan yang menarik. Begini cara ia berfungsi. Secara lalai, API Scrapestack sentiasa menggunakan proksi standard (pusat data) untuk mengikis permintaan. Dan walaupun ia adalah proksi yang paling biasa digunakan di internet, ia juga lebih berkemungkinan disekat apabila cuba mengikis data.

Jika anda melanggan Pelan Profesional atau lebih tinggi, API Scrapestack membenarkan akses kepada proksi premium (kediaman). Alamat tersebut dikaitkan dengan alamat kediaman sebenar dan oleh itu lebih kecil kemungkinannya untuk disekat semasa mengikis data di web. Seperti parameter pilihan lain, menggunakan pilihan ini hanyalah masalah menambahkan parameter premium_proxy pada permintaan pengikisan anda dan tetapkannya kepada 1.

https://api.screpestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & premium_proxy = 1

Walaupun kami boleh meneruskan untuk sementara waktu meliputi banyak pilihan yang tersedia dengan API Scrapestack , matlamat kami adalah untuk menyemak produk, bukan untuk menulis manual untuknya. Selain itu, tapak web Scrapestack mempunyai dokumentasi yang sangat teliti dan ia harus menjadi sumber utama maklumat cara untuk anda.

Maklumat Harga

The Scrapestack API perkhidmatan disediakan dengan beberapa pelan harga. Pada tahap yang paling rendah, Pelan Percuma menawarkan cara untuk membiasakan diri dengan API. Ia mempunyai fungsi API asas dan had 10 000 permintaan API setiap bulan. Jika anda perlu menjalankan lebih banyak pertanyaan atau memerlukan set ciri yang lebih maju, seperti permintaan serentak atau akses proksi premium, anda boleh memilih daripada salah satu pelan berbayar yang tersedia.

Dengan kebanyakan pelan berbayar yang menawarkan set ciri yang serupa, faktor penentu dalam hal keperluan teknikal anda selalunya ialah bilangan permintaan API yang perlu anda buat setiap bulan. Pembayaran boleh dibuat melalui kad kredit atau PayPal. Tambahan pula, pelanggan perusahaan dan volum tinggi boleh meminta pembayaran pindahan bank tahunan didayakan. Dan bercakap tentang pembayaran tahunan, memilih pilihan ini melayakkan anda mendapat diskaun 20% berbanding dengan bayaran bulanan, menjadikan produk lebih mampu milik. Dan jika anda tidak pasti tentang kekerapan pengebilan, ambil perhatian bahawa anda boleh (secara relatif) dengan mudah bertukar dari bulanan kepada tahunan dan kembali. Walau bagaimanapun, ia melibatkan penurunan taraf dahulu kepada pelan percuma dan serta-merta menaik taraf kepada pelan berbayar.

Pokoknya

Tidak kira betapa mudah atau betapa rumitnya keperluan mengikis web anda, API Scrapestack berkemungkinan besar boleh membantu anda mencapai matlamat anda dengan mudah dan mudah. Dengan kebolehpercayaan dan skalabiliti yang mengagumkan. Perkhidmatan berasaskan awan ini akan menyesuaikan diri dengan sempurna kepada hampir semua keadaan. Ia mempunyai semua pilihan yang mungkin diperlukan dan ia menawarkan cara untuk menipu percubaan mengikis anda di sebalik berjuta-juta alamat IP yang diproksi.

Masih tidak pasti sama ada API Scrapestack sesuai untuk anda? Apa kata anda memanfaatkan pelan percuma yang tersedia dan memberikan perkhidmatan itu sebagai percubaan. Saya agak pasti anda akan kagum kerana saya dengan kegunaan dan prestasi keseluruhannya.

Betulkan ralat ERR_TUNNEL_CONNECTION_FAILED dalam Chrome dengan penyelesaian terbukti ini. Ketahui punca dan cara menyelesaikannya dengan cepat.

Sesuatu yang saya benar-benar suka tentang Firefox dan sentiasa marah dalam Chrome ialah cara saya mengakses sambungan. Dalam Firefox, saya boleh memukul

Kami tahu bahawa semua perkhidmatan Google seperti Gmail, Kalendar, Peta, Google Drive dsb. secara kolektif dilabelkan Google Apps. Gergasi carian telah bersepadu

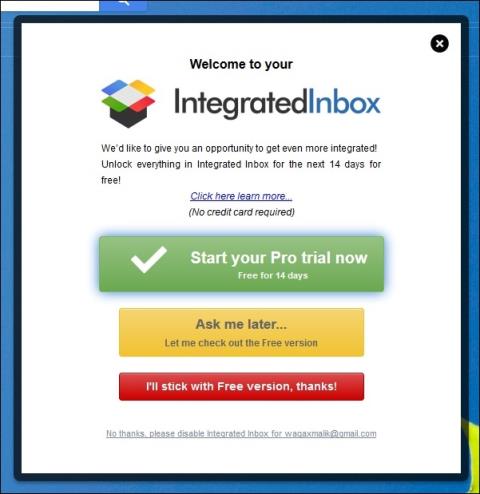

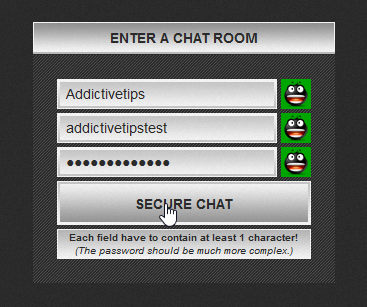

Gunakan ChatCrypt untuk pemesejan yang selamat dan disulitkan yang mengekalkan perbualan anda secara peribadi. Platform yang mudah digunakan direka untuk komunikasi sulit pada bila-bila masa, di mana sahaja.

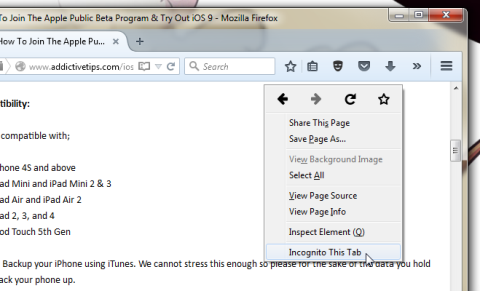

Dua tahun yang lalu, saya menjumpai alat tambah Firefox yang saya percaya adalah karya genius yang tulen namun mudah. Alat tambah yang dimaksudkan dipanggil Tab Peribadi dan ia

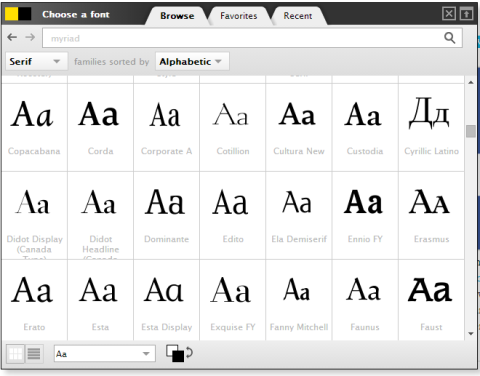

WebFonter ialah sambungan Chrome dan penanda buku yang membolehkan anda mencuba fon daripada FontShop yang menampilkan koleksi besar fon yang boleh anda beli.

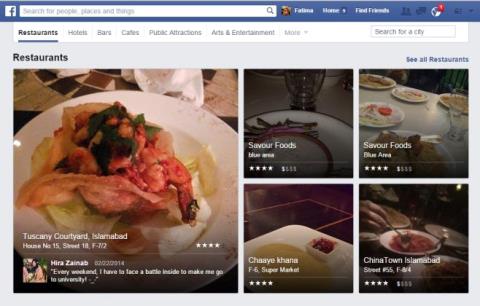

Bilangan apl yang dibangunkan untuk membantu orang mencari perkara menarik untuk dilakukan, mencari orang untuk melakukan sesuatu atau hanya mencari tempat makan yang baik adalah besar dan

Adakah anda tidak perlu membelanjakan wang untuk membeli barangan di Amazon hanya untuk mencari dompet anda kosong apabila anda paling memerlukannya? Tidak kira sedikit atau berapa banyak wang anda

Ketahui cara mengakses dan mengurus tetapan tapak dalam penyemak imbas anda. Kawal kebenaran untuk lokasi, kamera, mikrofon dan banyak lagi dalam Chrome.

Cari pelayar web proksi terbaik untuk penyemakan imbas tanpa nama, keselamatan dipertingkatkan dan pengurusan proksi yang lancar. Terokai pilihan teratas sekarang!

![Agoras Membolehkan Anda Membandingkan Produk Apabila Anda Membeli Item Dalam Talian [Chrome] Agoras Membolehkan Anda Membandingkan Produk Apabila Anda Membeli Item Dalam Talian [Chrome]](https://tips.webtech360.com/resources8/r252/image-5055-0829094639067.jpg)