Każda poprawka błędu ERR_TUNNEL_CONNECTION_FAILED

Napraw błąd ERR_TUNNEL_CONNECTION_FAILED w Chrome, korzystając z tych sprawdzonych rozwiązań. Poznaj przyczyny i dowiedz się, jak je szybko rozwiązać.

Web scraping może wydawać się prosty, ale w rzeczywistości może okazać się dość złożonym przedsięwzięciem. Wielu właścicieli witryn stara się aktywnie chronić przed tym, aby chronić swoje dane, co w większości uniemożliwia uruchamianie wewnętrznego skryptu, który wielokrotnie pobierał dane z docelowych witryn. Do wydajnego skrobania potrzebujesz specjalistycznego narzędzia, takiego jak API Scrapestack , które zamierzamy przejrzeć. Korzystając z niego, możesz szybko i skutecznie zeskrobać prawie każdą stronę internetową i wyodrębnić zawarte w niej informacje i dobrze je wykorzystać. Scrapestack zapewnia szybki i łatwy w użyciu oraz wysoce skalowalny sposób scrapowania stron internetowych.

Zanim przejdziemy do bardziej szczegółowych informacji na temat interfejsu API Scrapestack , zaczniemy od omówienia scrapingu. Wyjaśnimy, co to jest i dlaczego jest tak szeroko stosowany w Internecie. A mówiąc o Internecie, przyjrzymy się konkretnemu przypadkowi web scrapingu, ponieważ do tego właśnie został stworzony interfejs API Scrapestack, a także przedstawimy niektóre z najważniejszych powodów, dla których ktokolwiek miałby korzystać z usług innych firm. scraping API, taki jak ten. Po krótkim wyjaśnieniu, czym jest REST API, w końcu przejdziemy do sedna sprawy, gdy przedstawimy Scrapestack API. Najpierw omówimy produkt, zanim przeanalizujemy niektóre z jego najlepszych funkcji. Następnie przyjrzymy się, jak łatwe jest korzystanie z interfejsu API, zanim przedstawimy wielopoziomową strukturę cenową usługi.

Skrobanie w pigułce

Skrobanie danych to proces wydobywania danych z danych wyjściowych czytelnych dla człowieka, pochodzących z innego programu lub procesu. Różni się od innych form przesyłania danych na kilka sposobów. Transfer danych między programami odbywa się zwykle przy użyciu struktur danych przystosowanych do automatycznego przetwarzania przez komputery. Te formaty i protokoły wymiany mają sztywną strukturę, są dobrze udokumentowane, łatwo analizowane i minimalizują niejednoznaczność. Transmisje te zazwyczaj w ogóle nie są czytelne dla człowieka. Zostały zaprojektowane tak, aby były wydajne i szybkie. Głównym elementem odróżniającym zbieranie danych od innych form wymiany danych jest to, że dane wyjściowe, które są zeskrobane, są zwykle przeznaczone do wyświetlenia użytkownikowi końcowemu, a nie jako dane wejściowe do innego programu. W związku z tym rzadko jest dokumentowany lub ustrukturyzowany w celu wygodnego analizowania.

Istnieje kilka powodów, dla których można uciekać się do scrapingu danych. Na przykład najczęściej robi się to albo w celu połączenia się ze starszym systemem, który nie ma innego mechanizmu, który byłby kompatybilny z obecnymi mechanizmami transferowymi. Może być również używany do pobierania danych z systemu innej firmy, który nie zapewnia wygodniejszego interfejsu API. W tym ostatnim przypadku właściciel systemu innej firmy może postrzegać scraping danych jako niepożądany z powodów, takich jak zwiększone obciążenie systemu, utrata przychodów z reklam lub utrata kontroli nad zawartością informacji.

Tak szeroko rozpowszechnione, jak się stało, zbieranie danych jest zwykle uważane za doraźną, nieelegancką technikę, która jest często stosowana w ostateczności, gdy nie jest dostępny żaden inny mechanizm wymiany danych. Skrobanie danych często wiąże się z wyższymi kosztami programowania i przetwarzania, ponieważ wyświetlacze wyjściowe przeznaczone do spożycia przez ludzi często zmieniają strukturę. Podczas gdy ludzie mogą łatwo przystosować się do tych zmian, program komputerowy może nie, mając polecenie odczytywania danych w określonym formacie lub z określonej lokalizacji bez wiedzy, jak sprawdzić poprawność wyników.

Specyficzny przypadek skrobania sieci

Web scraping to po prostu specyficzny rodzaj skrobania danych, który służy do pobierania danych ze stron internetowych. Jak wiesz, strony internetowe są budowane przy użyciu tekstowych języków znaczników, takich jak HTML i XHTML. Są one jednak zazwyczaj przeznaczone dla użytkowników końcowych będących ludźmi, a nie dla łatwości zautomatyzowanego użytkowania. To jest główny powód, dla którego powstały web scrapery, takie jak Scrapestack API . Web scraper to interfejs API lub narzędzie, które wyodrębnia dane ze strony internetowej.

Ponieważ organizacje zwykle bardzo chronią swoje dane, główne witryny internetowe zwykle używają algorytmów obronnych, aby chronić je przed skrobakami sieciowymi. Mogą na przykład ograniczyć liczbę żądań, które może wysyłać IP lub sieć IP. Najlepsze narzędzia do web scrapingu zawierają mechanizmy przeciwdziałające tym zabezpieczeniom.

Korzystanie z zewnętrznego interfejsu API do scrapingu

Web scraping z prostej, statycznej strony internetowej jest raczej łatwy do zaimplementowania. Niestety, proste, statyczne strony internetowe to już odległa przeszłość, a większość nowoczesnych witryn korzysta z różnych technologii, aby zapewnić dynamiczną zawartość swoim odwiedzającym. W tym miejscu korzystanie z narzędzia innej firmy może być korzystne. Narzędzia te zajmą się wszystkimi podstawowymi szczegółami i pojawią się w witrynie, którą próbują zeskrobać jako zwykły użytkownik. Niektórzy posuną się nawet do wypełniania formularzy. Ale najlepszym powodem, dla którego ktokolwiek używałby narzędzia do skrobania innej firmy, takiego jak API Scrapestack, jest wygoda. Korzystanie z niego po prostu znacznie ułatwia sprawę.

Co to jest REST API?

API, co oznacza interfejs programowania aplikacji, jest środkiem do wywoływania jednego programu lub procesu z innego. Co więcej, wywoływany proces nie musi nawet działać na tym samym urządzeniu, co wywoływany. Jeśli chodzi o część REST, jest trochę bardziej skomplikowana. Spróbujmy wyjaśnić.

REST, co oznacza REpresentational State Transfer, to styl architektoniczny oprogramowania, który określa zestaw ograniczeń, które mają być używane do tworzenia usług internetowych. Te, które są zgodne ze stylem architektonicznym REST, nazywane są usługami sieciowymi RESTful i oferują interoperacyjność między systemami komputerowymi w Internecie. Ponadto umożliwiają systemom żądającym dostęp do tekstowych reprezentacji różnych zasobów sieciowych i manipulowanie nimi za pomocą jednolitego i wstępnie zdefiniowanego zestawu operacji bezstanowych.

Mówiąc prościej, interfejs API REST to taki, do którego można łatwo uzyskać dostęp za pomocą standardowych wywołań internetowych, takich jak HTTP „get”, „post”, „put” i „delete”, i które zwracają żądane dane w zorganizowany sposób. W konkretnym przypadku Scrapestack API wykorzystuje popularny format JSON. Wyniki można zatem łatwo przetwarzać przy użyciu popularnych języków, takich jak Javascript. Inne narzędzia mogą używać innych formatów — przy czym XML jest niezwykle popularny. Specyfikacja REST nakazuje tylko używanie stałego, wstępnie zdefiniowanego formatu.

Przedstawiamy API Scrapestack

Scrapestack API jest, trzeba mieć zorientowaliśmy się, REST API dla sieci web skrobanie. Krótko mówiąc, Scrapestack API może zmienić dowolną stronę internetową w przydatne dane. Jest to usługa API oparta na chmurze, która umożliwia użytkownikom przeglądanie witryn internetowych bez martwienia się o problemy techniczne, takie jak serwery proxy, blokowanie adresów IP, kierowanie geograficzne, rozwiązywanie problemów CAPTCHA i nie tylko. Aby z niego skorzystać, wystarczy podać prawidłowy adres URL witryny, a w ciągu zaledwie kilku milisekund interfejs API Scrapestack zwróci w odpowiedzi pełną zawartość HTML witryny. Otrzymana treść będzie wyglądać tak, jak widać w przeglądarce, w tym renderowanie JavaScript, a nie rzeczywisty kod, który jest częścią strony internetowej. Narzędzie jest zasilane przez jeden z najpotężniejszych silników do zgarniania sieci na rynku i oferuje jedno z najlepszych rozwiązań dla wszystkich Twoich wymagań dotyczących zgarniania.

Scrapestack API jest rozwijany i utrzymywany przez apilayer , firmy oprogramowania z siedzibą w Londynie, Wielka Brytania i Wiedeń, Austria. Jest to ta sama firma, która stoi za kilkoma popularnymi produktami API i SaaS na całym świecie, w tym weatherstack, fakturowanie i eversign. Z tej potężnej infrastruktury korzysta ponad 2000 organizacji na całym świecie. Obecnie usługa online, która została stworzona do przetwarzania milionów adresów IP proxy, przeglądarek i kodów CAPTCHA, obsługuje ponad miliard żądań każdego miesiąca i może pochwalić się imponującym średnim czasem pracy na poziomie 99,9%. Gwarantuje to, że usługa będzie dostępna, gdy jej potrzebujesz.

Przewodnik po głównych funkcjach API Scrapestack

Jeśli chodzi o funkcje , Scrapestack API nie pozostawia wiele do życzenia, bez względu na to, dlaczego musisz zeskrobać strony internetowe lub jakie dane próbujesz uzyskać, produkt najprawdopodobniej doskonale pasuje do Twoich potrzeb. Przyjrzyjmy się pokrótce niektórym z najważniejszych funkcji tego narzędzia.

Miliony serwerów proxy i adresów IP

Jednym ze sposobów ochrony stron internetowych przed scrapingiem jest identyfikowanie źródłowych adresów IP generujących wiele kolejnych żądań. Z tego powodu narzędzie do skrobania stron internetowych musi korzystać z różnych adresów IP dla każdego żądania. W API Scrapestack adresy to poprzez oferowanie obszerną pulę centrum ponad trzydzieści pięć milionów danych i adresów IP przez serwer proxy mieszkalnych rozłożone dziesiątkach światowych dostawców usług internetowych, a także poprzez wspieranie prawdziwych urządzeń, inteligentne ponownych prób i obrót IP. Gwarantuje to, że Twoje prośby o skrobanie najprawdopodobniej pozostaną niezauważone w witrynach, które są skrobane.

Najczęstsze są serwery proxy centrum danych lub „standardowe”. Nie są własnością żadnego konkretnego dostawcy usług internetowych i po prostu maskują twój pierwotny adres IP, pokazując źródłowy adres IP serwera proxy centrum danych oraz informacje powiązane z firmą, która jest właścicielem odpowiedniego centrum danych.

Jeśli chodzi o serwery proxy do użytku domowego lub „premium”, zapewniają one adresy IP, które są połączone z rzeczywistymi adresami mieszkalnymi i urządzeniami domowymi. To sprawia, że są znacznie mniej podatne na zablokowanie podczas zdrapywania sieci. Korzystanie z domowych serwerów proxy do przeszukiwania sieci ułatwia obchodzenie się z treściami blokowanymi geograficznie i zbieranie dużych ilości danych.

Ponad sto globalnych lokalizacji

Niektóre witryny zwracają różne informacje w zależności od lokalizacji, z której pochodzi żądanie. Podobnie niektóre witryny będą akceptować żądania tylko z określonych lokalizacji. Jednym z takich przykładów jest strona internetowa taka jak Netflix, która akceptuje tylko lokalne połączenia przychodzące. Dostęp do amerykańskiego serwisu Netflix można uzyskać tylko z adresów IP w Stanach Zjednoczonych, a do serwisu kanadyjskiego można uzyskać dostęp tylko z kanadyjskich adresów IP. Scrapestack API może pozwolić wybierać spośród ponad stu światowych obsługiwanych lokalizacji do wysyłania żądań skrobanie web API. Masz również możliwość korzystania z losowych celów geograficznych, obsługujących szereg głównych miast na całym świecie.

Solidna infrastruktura

Usługa oparta na chmurze, taka jak API Scrapestack, jest tak dobra, jak infrastruktura, na której jest zbudowana. W związku z tym jest to solidna usługa z imponującym czasem pracy bez przestojów. Korzystanie z usługi pozwala na zdrapywanie sieci z niespotykaną szybkością. Skorzystasz również z szeregu zaawansowanych funkcji, takich jak współbieżne żądania API, rozwiązywanie CAPTCHA, obsługa przeglądarek i renderowanie JS. Usługa jest zbudowana na infrastrukturze chmury apilayer . Dzięki temu usługa jest wysoce skalowalna i może obsłużyć wszystko, od zaledwie tysięcy żądań API miesięcznie do milionów dziennie. Jest zasilany przez system, który skaluje się w górę i w dół w zależności od potrzeb i może zapewnić najwyższy możliwy czas odpowiedzi na każde żądanie API na dowolnym poziomie wykorzystania.

Korzystanie z API Scrapestack

Korzystanie z API Scrapestack jest tak proste, jak to tylko możliwe. Pierwszym krokiem jest oczywiście utworzenie konta. Utworzenie go ujawni Twój unikalny klucz dostępu do interfejsu API, którego musisz użyć przy każdym żądaniu, aby uwierzytelnić się za pomocą interfejsu API. Robisz to, dołączając parametr access_key do podstawowego adresu URL API i ustawiając go na klucz dostępu API.

https://api.scrapestack.com/scrape ? klucz_dostępu = TWÓJ_KLUCZ_DOSTĘPU

Płatne plany obsługują 256-bitowe szyfrowanie HTTPS. Aby z niego skorzystać, wystarczy użyć HTTPS zamiast HTTP w wywołaniach API.

Najbardziej podstawowy typ żądania jest trafnie nazywany żądaniem „podstawowym”. W najbardziej podstawowej formie wystarczy podać klucz dostępu API i adres URL strony, którą chcesz zeskrobać. Na przykład, aby zeskrobać stronę https://apple.com, żądanie wyglądałoby tak:

https://api.scrapestack.com/scrape ? access_key = TWÓJ_KLUCZ_DOSTĘPU i adres URL = https://apple.com

Zwróć uwagę, że istnieje kilka opcjonalnych parametrów, które można dodać do żądań. Niektóre z nich omówimy bardziej szczegółowo za chwilę.

Po pomyślnym wykonaniu interfejs API odpowiada nieprzetworzonymi danymi HTML docelowego adresu URL strony internetowej. Oto jak wygląda typowa odpowiedź z podstawowego żądania. Zwróć uwagę, że został skrócony ze względu na czytelność. Rzeczywista odpowiedź zawierałaby cały kod w obrębie

oraz

Sekcje.

[...] // 44 wiersze pominięte [...] // 394 wiersze pominięte

Parametry opcjonalne

Pierwszym i najczęściej używanym parametrem opcjonalnym jest z pewnością JavaScript Rendering . Jest dostępny we wszystkich płatnych planach. Jak wiesz, niektóre strony internetowe renderują podstawowe elementy strony za pomocą JavaScript. Oznacza to, że niektóre treści nie są obecne – a zatem nie można ich zeskrobać – przy początkowym załadowaniu strony. Po włączeniu parametru render_js interfejs API Scrapestack uzyska dostęp do sieci docelowej za pomocą przeglądarki bezgłowej (Google Chrome) i umożliwi renderowanie elementów strony JavaScript przed dostarczeniem końcowego wyniku skrobania. Włączenie tej opcji to prosta kwestia dodania parametru render_js do adresu URL żądania interfejsu API i ustawienia go na 1.

https://api.scrapestack.com/scrape ? access_key = TWÓJ_KLUCZ_DOSTĘPU i url = https://apple.com & render_js = 1

Kolejnym przydatnym parametrem opcjonalnym jest możliwość określenia lokalizacji proxy , dostępna również we wszystkich płatnych planach. Scrapestack API wykorzystuje pulę ponad 35 milionów adresów IP na całym świecie. Domyślnie automatycznie rotuje adresy IP w taki sposób, że ten sam adres IP nigdy nie jest używany dwa razy z rzędu. Korzystając z opcjonalnego parametru proxy_location interfejsu API, możesz wybrać konkretny kraj, podając jego dwuliterowy kod kraju. Na przykład poniższy przykład określa au (Australia) jako lokalizację proxy. Zapytanie zostanie zatem uruchomione z adresu IP znajdującego się w Australii.

https://api.scrapestack.com/scrape ? access_key = TWÓJ_KLUCZ_DOSTĘPU i adres URL = https://apple.com i proxy_location = au

Premium proxy to kolejna ciekawa opcja. Oto jak to działa. Domyślnie interfejs API Scrapestack zawsze używa standardowych serwerów proxy (centrum danych) do zdrapywania żądań. I chociaż są to najczęstsze serwery proxy używane w Internecie, są również znacznie bardziej narażone na zablokowanie podczas próby zeskrobywania danych.

Jeśli subskrybujesz plan Professional lub wyższy, interfejs API Scrapestack umożliwia dostęp do serwerów proxy premium (mieszkalnych). Są one powiązane z prawdziwymi adresami mieszkalnymi, a zatem znacznie mniej prawdopodobne jest, że zostaną zablokowane podczas pobierania danych w sieci. Podobnie jak w przypadku innych opcjonalnych parametrów, użycie tej opcji to tylko kwestia dołączenia parametru premium_proxy do żądania skrobania i ustawienia go na 1.

https://api.scrapestack.com/scrape ? access_key = TWÓJ_KLUCZ_DOSTĘPU i adres URL = https://apple.com i premium_proxy = 1

Chociaż moglibyśmy przez dłuższy czas omawiać wiele opcji dostępnych w interfejsie API Scrapestack , naszym celem jest przejrzenie produktu, a nie napisanie do niego instrukcji. Poza tym strona Scrapestack ma bardzo dokładną dokumentację i powinna być twoim głównym źródłem informacji.

Informacje o cenie

Scrapestack API usługi dostępne w ramach kilku planów cenowych jest. Na najniższym poziomie Plan bezpłatny oferuje sposób na zapoznanie się z API. Posiada podstawową funkcjonalność API i ograniczenie do 10 000 zapytań API miesięcznie. Jeśli potrzebujesz uruchomić więcej zapytań lub potrzebujesz bardziej zaawansowanego zestawu funkcji, takich jak równoczesne żądania lub dostęp do premium proxy, możesz wybrać jeden z dostępnych płatnych planów.

W przypadku większości płatnych planów oferujących podobny zestaw funkcji, decydującym czynnikiem, jeśli chodzi o wymagania techniczne, będzie często liczba żądań API, które musisz składać co miesiąc. Płatności można dokonać kartą kredytową lub PayPal. Ponadto klienci korporacyjni i klienci o dużym wolumenie mogą poprosić o włączenie rocznych płatności przelewem bankowym. A skoro mowa o płatności rocznej, wybranie tej opcji uprawnia do 20% rabatu w stosunku do płatności miesięcznych, dzięki czemu produkt jest jeszcze bardziej przystępny cenowo. A jeśli nie masz pewności co do częstotliwości rozliczeń, pamiętaj, że możesz (stosunkowo) łatwo przełączyć się z miesięcznego na roczny iz powrotem. Wiąże się to jednak najpierw z przejściem na plan bezpłatny i natychmiastową uaktualnieniem do planu płatnego.

Dolna linia

Bez względu na to, jak proste lub złożone mogą być Twoje potrzeby związane ze skrobaniem stron internetowych, interfejs API Scrapestack najprawdopodobniej pomoże Ci w prosty i bezproblemowy sposób osiągnąć Twoje cele. Z imponującą niezawodnością i skalowalnością. Ta usługa w chmurze bezbłędnie dostosuje się do niemal każdej sytuacji. Ma wszystkie opcje, których możesz potrzebować, i oferuje środki do sfałszowania twoich prób skrobania za milionami adresów IP proxy.

Nadal nie jesteś pewien, czy interfejs API Scrapestack jest dla Ciebie odpowiedni? Dlaczego nie skorzystać z dostępnego darmowego planu i przetestować usługę. Jestem prawie pewien, że będziesz zachwycony, podobnie jak ja, jego ogólną użytecznością i wydajnością.

Napraw błąd ERR_TUNNEL_CONNECTION_FAILED w Chrome, korzystając z tych sprawdzonych rozwiązań. Poznaj przyczyny i dowiedz się, jak je szybko rozwiązać.

Coś, co absolutnie uwielbiam w Firefoksie i co ciągle mnie irytuje w Chrome, to sposób dostępu do rozszerzeń. W Firefoksie mogę kliknąć

Wiemy, że wszystkie usługi Google, takie jak Gmail, Kalendarz, Mapy, Dysk Google itp., są zbiorczo określane jako Aplikacje Google. Gigant wyszukiwania zintegrował

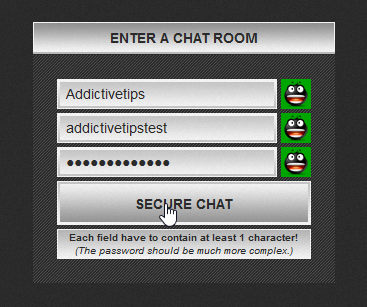

Korzystaj z ChatCrypt, aby wysyłać bezpieczne, szyfrowane wiadomości i zachować prywatność swoich rozmów. Łatwa w obsłudze platforma zaprojektowana z myślą o poufnej komunikacji w dowolnym miejscu i czasie.

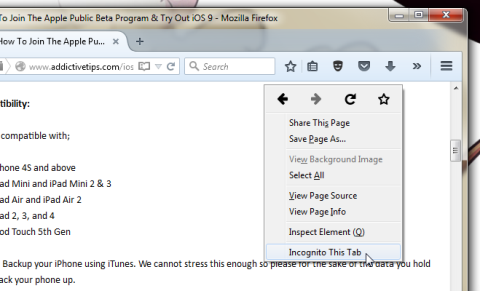

Dobre dwa lata temu znalazłem dodatek do Firefoksa, który uznałem za czyste, a zarazem proste dzieło geniuszu. Dodatek, o którym mowa, nazywa się „Prywatna karta” i…

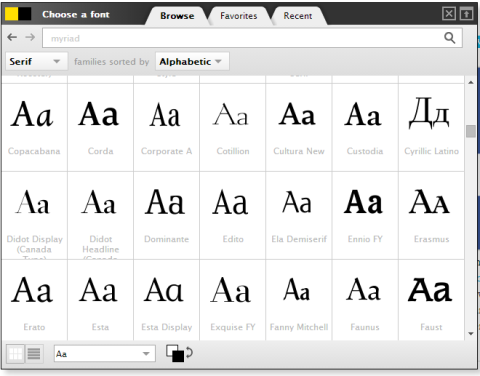

WebFonter to rozszerzenie przeglądarki Chrome oraz zakładka umożliwiająca wypróbowywanie czcionek z FontShop, gdzie znajduje się duża kolekcja czcionek dostępnych do kupienia.

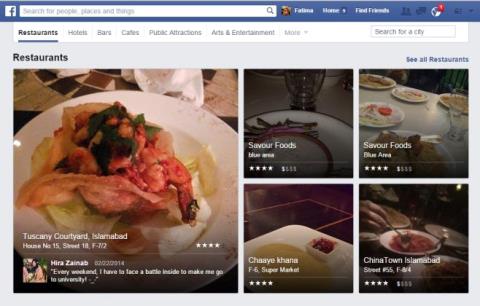

Ogromna jest liczba aplikacji, które pomagają ludziom znaleźć ciekawe rzeczy do zrobienia, znaleźć osoby, z którymi można spędzić czas, lub po prostu znaleźć dobre miejsce do jedzenia.

Czy niepotrzebnie wydajesz pieniądze na zakupy na Amazonie, a potem okazuje się, że Twój portfel jest pusty, kiedy najbardziej go potrzebujesz? Niezależnie od tego, jak mało czy ile pieniędzy posiadasz

Dowiedz się, jak uzyskać dostęp do ustawień witryny i zarządzać nimi w przeglądarce. Kontroluj uprawnienia do lokalizacji, aparatu, mikrofonu i innych funkcji w Chrome.

Znajdź najlepszą przeglądarkę proxy do anonimowego przeglądania stron internetowych, zwiększonego bezpieczeństwa i płynnego zarządzania proxy. Poznaj najlepsze opcje już teraz!

![Agora umożliwia porównywanie produktów podczas zakupów online [Chrome] Agora umożliwia porównywanie produktów podczas zakupów online [Chrome]](https://tips.webtech360.com/resources8/r252/image-5055-0829094639067.jpg)