Все исправления ошибки ERR_TUNNEL_CONNECTION_FAILED

Исправьте ошибку ERR_TUNNEL_CONNECTION_FAILED в Chrome с помощью этих проверенных решений. Узнайте о причинах и способах их быстрого устранения.

Парсинг веб-страниц может показаться простым, но на самом деле может оказаться довольно сложным занятием. Многие владельцы веб-сайтов пытаются активно защищаться от него, чтобы защитить свои данные, что в большинстве случаев препятствует запуску внутреннего сценария для многократного извлечения данных с целевых веб-сайтов. Для эффективного парсинга вам понадобится специализированный инструмент, такой как Scrapestack API, который мы собираемся рассмотреть. Используя его, вы можете быстро и эффективно очистить практически любой веб-сайт, извлечь содержащуюся на нем информацию и найти ей хорошее применение. Scrapestack обеспечивает быстрый, простой в использовании и хорошо масштабируемый способ очистки веб-сайтов.

Прежде чем мы углубимся в подробности API Scrapestack , мы начнем с обсуждения парсинга. Мы объясним, что это такое и почему он так широко используется в Интернете. И, говоря об Интернете, мы затем рассмотрим конкретный случай парсинга веб-страниц, поскольку это то, для чего создан Scrapestack API , и мы также представим некоторые из наиболее важных причин, по которым кто-либо будет использовать сторонний парсинг API, подобный этому. Кратко объяснив, что такое REST API, мы, наконец, дойдем до сути вопроса, когда представим Scrapestack API.. Сначала мы сделаем обзор продукта, прежде чем продолжить анализ некоторых из его лучших функций. Мы рассмотрим, насколько легко использовать API, прежде чем представить многоуровневую структуру ценообразования службы.

Соскоб в двух словах

Очистка данных - это процесс извлечения данных из удобочитаемых выходных данных, поступающих из другой программы или процесса. Он отличается от других форм передачи данных несколькими способами. Передача данных между программами обычно осуществляется с использованием структур данных, пригодных для автоматизированной обработки на компьютерах. Эти форматы и протоколы обмена жестко структурированы, хорошо документированы, легко анализируются и сводят к минимуму двусмысленность. Эти передачи обычно вообще не читаются человеком. Они созданы, чтобы быть эффективными и быстрыми. Основным элементом, который отличает очистку данных от других форм обмена данными, является то, что очищаемый вывод обычно предназначен для отображения конечному пользователю, а не в качестве ввода для другой программы. Поэтому он редко документируется или структурируется для удобного анализа.

Есть несколько причин, по которым можно прибегнуть к очистке данных. Например, чаще всего это делается либо для взаимодействия с унаследованной системой, у которой нет другого механизма, совместимого с текущими механизмами передачи. Его также можно использовать для получения данных из сторонней системы, которая не предоставляет более удобный API. В этом последнем случае владелец сторонней системы может рассматривать извлечение данных как нежелательное из-за таких причин, как повышенная нагрузка на систему, потеря доходов от рекламы или потеря контроля над информационным содержанием.

Каким бы распространенным он ни стал, очистка данных обычно считается специальной, неэлегантной техникой, которая часто используется как последнее средство, когда нет другого механизма для обмена данными. Очистка данных часто связана с более высокими накладными расходами на программирование и обработку, поскольку выходные данные, предназначенные для потребления человеком, часто меняют структуру. В то время как люди могут легко адаптироваться к этим изменениям, компьютерная программа может не адаптироваться, поскольку им было сказано читать данные в определенном формате или из определенного места, не зная, как проверить результаты на достоверность.

Конкретный случай парсинга веб-страниц

Очистка веб-страниц - это просто определенный тип очистки данных, который используется для извлечения данных с веб-страниц. Как вы знаете, веб-страницы создаются с использованием текстовых языков разметки, таких как HTML и XHTML. Однако они, как правило, предназначены для конечных пользователей-людей, а не для простоты автоматизированного использования. Это основная причина создания веб- парсеров, таких как Scrapestack API . Веб-парсер - это API или инструмент, который извлекает данные с веб-сайта.

Поскольку организации, как правило, очень сильно защищают свои данные, крупные веб-сайты обычно используют защитные алгоритмы, чтобы защитить их от веб-парсеров. Они могут, например, ограничить количество запросов, которые может отправлять IP- или IP-сеть. Лучшие инструменты для очистки веб-страниц включают механизмы для противодействия этой защите.

Использование стороннего API парсинга

Скрипинг веб-страниц с простой статической веб-страницы, как правило, довольно легко реализовать. К сожалению, простые статические веб-страницы ушли в далекое прошлое, и большинство современных веб-сайтов прибегают к различным технологиям, чтобы предоставлять своим посетителям динамический контент. Именно здесь может оказаться полезным использование стороннего инструмента. Эти инструменты будут обрабатывать все основные детали и отображаться на веб-сайте, который они пытаются очистить, как обычный пользователь. Некоторые даже дойдут до заполнения форм за вас. Но лучшая причина, по которой кто-то может использовать сторонний инструмент для очистки, такой как Scrapestack API, - это удобство. Его использование значительно упрощает работу.

Что такое REST API?

API, который означает интерфейс прикладного программирования, является средством вызова одной программы или процесса из другой. Более того, вызываемый процесс даже не обязательно должен работать на том же устройстве, что и вызываемый. Что касается части REST, то она немного сложнее. Попробуем объяснить.

REST, что означает REpresentational State Transfer, представляет собой архитектурный стиль программного обеспечения, который описывает набор ограничений, которые будут использоваться для создания веб-сервисов. Те, которые соответствуют архитектурному стилю REST, называются веб-службами RESTful, и они обеспечивают взаимодействие между компьютерными системами в Интернете. Кроме того, они позволяют запрашивающим системам получать доступ и управлять текстовыми представлениями различных веб-ресурсов с помощью унифицированного и предопределенного набора операций без сохранения состояния.

Проще говоря, REST API - это тот, к которому можно легко получить доступ с помощью стандартных веб-вызовов, таких как HTTP «get», «post», «put» и «delete», которые возвращают запрошенные данные в организованном виде. В конкретном случае Scrapestack API используется популярный формат JSON. Таким образом, результаты могут быть легко обработаны с использованием распространенных языков, таких как Javascript. Другие инструменты могут использовать другие форматы, при этом XML очень популярен. Спецификация REST требует только использования фиксированного предопределенного формата.

Представляем Scrapestack API

Scrapestack API , вы должны вычислял его вне, REST API для веб - соскоб. Вкратце, Scrapestack API может превратить любую веб-страницу в полезные данные. Это облачный API-сервис, который позволяет пользователям очищать веб-сайты, не беспокоясь о технических проблемах, таких как прокси, IP-блоки, геотаргетинг, решение CAPTCHA и т. Д. Чтобы использовать его, вы просто даете ему действительный URL-адрес веб-сайта, и всего за несколько миллисекунд API Scrapestack вернет в качестве ответа полное HTML-содержимое сайта. Полученный вами контент будет отображаться в том виде, в котором он отображается в браузере, включая любой рендеринг JavaScript, а не фактический код, являющийся частью веб-страницы. Инструмент работает на базе одного из самых мощных на рынке движков парсинга веб-страниц и предлагает одно из лучших решений для всех ваших требований к парсеру.

Scrapestack API разработан и поддерживается apilayer , программное обеспечение компании , базирующейся в Лондоне, Великобритании и Вене, Австрия. Это та же компания, которая стоит за несколькими популярными во всем мире продуктами API и SaaS, включая weatherstack, invoicely и eversign. Эту мощную инфраструктуру используют более 2000 организаций по всему миру. В настоящее время онлайн-сервис, созданный для обработки миллионов IP-адресов прокси, браузеров и CAPTCHA, обрабатывает более миллиарда запросов каждый месяц и может похвастаться впечатляющим средним временем безотказной работы 99,9%. Это гарантирует, что услуга будет доступна тогда, когда она вам понадобится.

Обзор основных функций Scrapestack API

С точки зрения функций Scrapestack API не оставляет желать лучшего, независимо от того, зачем вам нужно очищать веб-сайты или какие данные вы пытаетесь получить, продукт, скорее всего, идеально подходит для ваших нужд. Давайте кратко рассмотрим некоторые из наиболее важных функций этого инструмента.

Миллионы прокси и IP-адресов

Один из способов защиты веб-сайтов от парсинга - определение исходных IP-адресов, генерирующих несколько последовательных запросов. По этой причине инструмент для очистки веб-страниц должен прибегать к использованию разных IP-адресов для каждого запроса. В API Scrapestack адрес этого, предлагая обширный бассейн центра в течение тридцати пяти миллионов данных и жилого проксируемого IP адрес разбросан по десяткам глобальных провайдеров Интернета - услуг, а также поддержки реальных устройств, интеллектуальные попыток и ротации IP. Это гарантирует, что ваши запросы на парсинг, скорее всего, останутся незамеченными для сайтов, которые обрабатываются.

Центры обработки данных или «стандартные» прокси - самые распространенные. Они не принадлежат какому-либо конкретному интернет-провайдеру и просто маскируют ваш исходный IP-адрес, показывая исходный IP-адрес прокси-сервера центра обработки данных и информацию, связанную с компанией, которой принадлежит соответствующий центр обработки данных.

Что касается домашних или «премиальных» прокси, они предоставляют IP-адреса, которые связаны с реальными домашними адресами и домашними устройствами. Это снижает вероятность того, что они будут заблокированы при сканировании Интернета. Использование резидентных прокси для парсинга веб-страниц позволяет легко обходить геоблокированный контент и собирать большие объемы данных.

Более сотни офисов по всему миру

Некоторые веб-сайты будут возвращать различную информацию в зависимости от того, откуда исходит запрос. Точно так же некоторые сайты будут принимать запросы только из определенных мест. Одним из таких примеров является такой веб-сайт, как Netflix, который принимает только локальные входящие соединения. Доступ к Netflix в США можно получить только с IP-адресов в США, а к канадскому Netflix можно получить доступ только с IP-адресов Канады. Scrapestack API может позволить вам выбрать из более чем ста поддерживаемых глобальных мест , чтобы отправить веб - соскоб запросы API. У вас также есть возможность использовать случайные географические цели, поддерживающие ряд крупных городов по всему миру.

Надежная инфраструктура

Облачная служба, такая как Scrapestack API, хороша ровно настолько, насколько хороша инфраструктура, на которой она построена. В этом смысле это надежный сервис с впечатляющим временем безотказной работы. Использование сервиса позволяет сканировать Интернет с беспрецедентной скоростью. Вы также получите выгоду от множества расширенных функций, таких как одновременные запросы API, решение CAPTCHA, поддержка браузера и рендеринг JS. Сервис построен на основе двухуровневой облачной инфраструктуры. Это делает сервис хорошо масштабируемым и способным обрабатывать все, от тысяч запросов API в месяц до миллионов в день. Он питается от системы, которая масштабируется вверх и вниз по мере необходимости, и может обеспечить максимально возможное время ответа на любой запрос API на любом уровне использования.

Использование Scrapestack API

Использовать Scrapestack API настолько просто, насколько это возможно. Первым шагом, конечно же, является создание учетной записи. Его создание покажет ваш уникальный ключ доступа к API, который вы должны использовать с каждым запросом для аутентификации с помощью API. Вы делаете это, просто добавляя параметр access_key к базовому URL-адресу API и устанавливая его в свой ключ доступа к API.

https://api.scrapestack.com/scrape? access_key = ВАШ_ACCESS_KEY

Платные планы поддерживают 256-битное шифрование HTTPS. Чтобы использовать его, все, что вам нужно сделать, это использовать HTTPS вместо HTTP в ваших вызовах API.

Самый простой тип запроса удачно называется «базовым» запросом. В его наиболее элементарной форме вам просто нужно указать ключ доступа к API и URL-адрес страницы, которую вы хотите очистить. Например, для очистки страницы https://apple.com запрос будет выглядеть так:

https://api.scrapestack.com/scrape? access_key = YOUR_ACCESS_KEY & url = https://apple.com

Обратите внимание, что есть несколько необязательных параметров, которые можно добавить к вашим запросам. Мы обсудим некоторые из них более подробно чуть позже.

После успешного выполнения API отвечает необработанными данными HTML URL вашей целевой веб-страницы. Вот как выглядит типичный ответ на базовый запрос. Обратите внимание, что он был сокращен для удобства чтения. Фактический ответ будет включать весь код из

и

разделы.

[...] // 44 строки пропущены [...] // 394 строки пропущены

Дополнительные параметры

Первым и наиболее часто используемым необязательным параметром, безусловно, является рендеринг JavaScript . Доступно на всех платных планах. Как вы знаете, некоторые веб-страницы отображают важные элементы страницы с помощью JavaScript. Это означает, что некоторый контент отсутствует - и, следовательно, не подлежит очистке - при начальной загрузке страницы. При включенном параметре render_js Scrapestack API будет обращаться к целевой сети с помощью браузера без заголовка (Google Chrome) и разрешать отображение элементов страницы JavaScript перед доставкой окончательного результата очистки. Чтобы включить эту опцию, просто добавьте параметр render_js к URL-адресу запроса API и установите для него значение 1.

https://api.scrapestack.com/scrape? access_key = YOUR_ACCESS_KEY & url = https://apple.com & render_js = 1

Еще один полезный необязательный параметр - это возможность указывать расположение прокси , также доступную на всех платных планах. Scrapestack API использует пул более 35 миллионов IP - адресов по всему миру. По умолчанию он автоматически меняет IP-адреса таким образом, чтобы один и тот же IP-адрес никогда не использовался дважды подряд. Используя необязательный параметр API proxy_location, вы можете выбрать конкретную страну, указав ее двухбуквенный код страны. Например, в приведенном ниже примере в качестве прокси-сервера указан au (Австралия). Таким образом, запрос будет запущен с австралийского IP-адреса.

https://api.scrapestack.com/scrape? access_key = YOUR_ACCESS_KEY & url = https://apple.com & proxy_location = au

Премиум Доверенный еще один интересный вариант. Вот как это работает. По умолчанию Scrapestack API всегда использует стандартные прокси (центры обработки данных) для очистки запросов. И хотя они являются наиболее распространенными прокси, используемыми в Интернете, они также с гораздо большей вероятностью будут заблокированы при попытке очистить данные.

Если вы подписаны на Профессиональный план или выше, Scrapestack API разрешает доступ к премиум (резидентным) прокси. Они связаны с реальными адресами проживания и, следовательно, с меньшей вероятностью будут заблокированы при сканировании данных в Интернете. Как и другие необязательные параметры, использование этого параметра сводится к добавлению параметра premium_proxy к вашему запросу на парсинг и установке для него значения 1.

https://api.scrapestack.com/scrape? access_key = YOUR_ACCESS_KEY & url = https://apple.com & premium_proxy = 1

Хотя мы могли бы довольно долго рассматривать многие варианты, доступные с помощью Scrapestack API , наша цель - изучить продукт, а не написать для него руководство. Кроме того, на веб- сайте Scrapestack есть очень подробная документация, и он должен быть вашим основным источником практической информации.

Информация о ценах

API Scrapestack сервис доступен по несколько тарифных планам. На самом низком уровне бесплатный план предлагает способ познакомиться с API. Он имеет базовую функциональность API и ограничение в 10 000 запросов API в месяц. Если вам нужно выполнить больше запросов или вам нужен более расширенный набор функций, таких как одновременные запросы или доступ к премиум-прокси, вы можете выбрать один из доступных платных планов.

Поскольку большинство платных планов предлагают аналогичный набор функций, решающим фактором, когда дело доходит до ваших технических требований, часто будет количество запросов API, которые вам нужно выполнять на ежемесячной основе. Оплата может производиться кредитной картой или через PayPal. Кроме того, корпоративные и крупные клиенты могут запросить возможность ежегодных платежей банковским переводом. Что касается годовой оплаты, то выбор этой опции дает вам право на 20% скидку по сравнению с ежемесячными платежами, что делает продукт еще более доступным. И если вы не уверены в частоте выставления счетов, обратите внимание, что вы можете (относительно) легко переключиться с ежемесячного на годовой и обратно. Однако для этого необходимо сначала перейти на бесплатный план и сразу перейти на платный.

Нижняя линия

Независимо от того, насколько простым или сложным может быть ваш веб- парсинг , Scrapestack API, скорее всего, поможет вам легко и без усилий достичь ваших целей. С впечатляющей надежностью и масштабируемостью. Этот облачный сервис безупречно адаптируется практически к любой ситуации. В нем есть все необходимые параметры, и он предлагает средства для обмана ваших попыток очистки миллионов проксированных IP-адресов.

Все еще не уверены, подходит ли вам Scrapestack API ? Почему бы вам не воспользоваться доступным бесплатным планом и не запустить пробную версию службы. Я почти уверен, что вы, как и я, будете просто поражены его общей полезностью и производительностью.

Исправьте ошибку ERR_TUNNEL_CONNECTION_FAILED в Chrome с помощью этих проверенных решений. Узнайте о причинах и способах их быстрого устранения.

Что мне безумно нравится в Firefox и что постоянно раздражает в Chrome, так это то, как я получаю доступ к расширениям. В Firefox я могу нажать

Мы знаем, что все сервисы Google, такие как Gmail, Календарь, Карты, Google Диск и т. д., вместе называются Google Apps. Поисковый гигант интегрировал

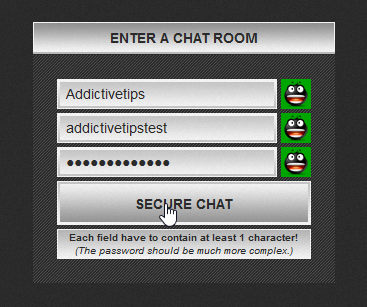

Используйте ChatCrypt для безопасного, зашифрованного обмена сообщениями, сохраняющего конфиденциальность ваших разговоров. Простая в использовании платформа, разработанная для конфиденциального общения в любое время и в любом месте.

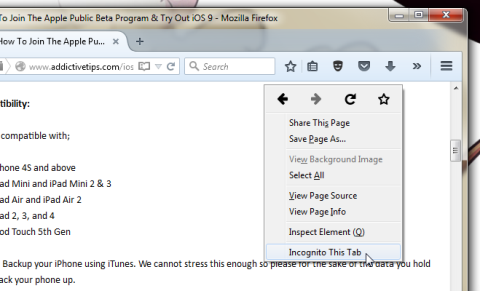

Года два назад я наткнулся на дополнение для Firefox, которое, по моему мнению, было гениальным, но в то же время простым творением. Это дополнение называется Private Tab, и оно…

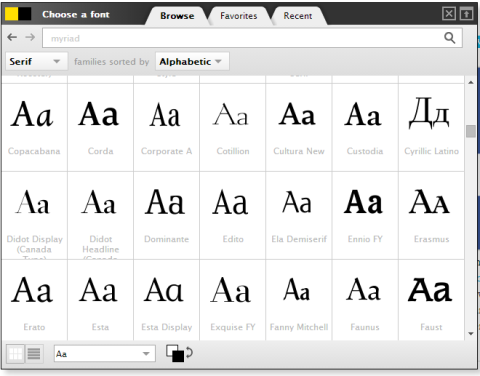

WebFonter — это расширение Chrome и букмарклет, позволяющий вам пробовать шрифты из FontShop, в котором представлена большая коллекция шрифтов, доступных для покупки.

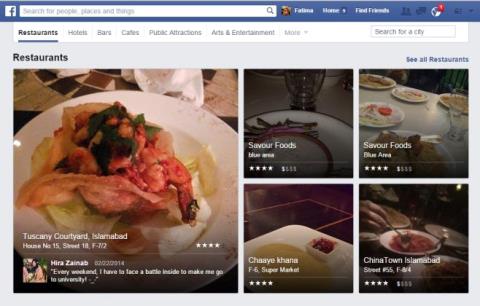

Количество приложений, разработанных для того, чтобы помочь людям найти интересные занятия, найти людей, с которыми можно провести время, или просто найти хорошее место, где можно поесть, огромно и

Вы тратите деньги на покупки на Amazon, а потом обнаруживаете, что ваш кошелёк пуст, когда он вам больше всего нужен? Неважно, сколько у вас денег.

Узнайте, как получить доступ к настройкам сайтов и управлять ими в браузере. Управляйте разрешениями на доступ к данным о местоположении, камере, микрофону и другим функциям в Chrome.

Найдите лучший прокси-браузер для анонимного просмотра, повышенной безопасности и удобного управления прокси-серверами. Ознакомьтесь с лучшими вариантами прямо сейчас!

![Agora позволяет сравнивать товары при покупке онлайн [Chrome] Agora позволяет сравнивать товары при покупке онлайн [Chrome]](https://tips.webtech360.com/resources8/r252/image-5055-0829094639067.jpg)