Alle oplossingen voor de fout ERR_TUNNEL_CONNECTION_FAILED

Los de fout ERR_TUNNEL_CONNECTION_FAILED in Chrome op met deze bewezen oplossingen. Ontdek de oorzaken en hoe u deze snel kunt oplossen.

Webscraping lijkt misschien eenvoudig, maar het kan in werkelijkheid een nogal complexe onderneming blijken te zijn. Veel website-eigenaren proberen er actief tegen te beschermen om hun gegevens te beschermen, wat meestal het uitvoeren van een intern script uitsluit om herhaaldelijk gegevens van doelwebsites te halen. Voor efficiënt schrapen hebt u een gespecialiseerde tool nodig, zoals de Scrapestack API die we binnenkort gaan beoordelen. Als je het gebruikt, kun je snel en efficiënt bijna elke website schrapen en de informatie die het bevat extraheren en goed gebruiken. Scrapestack biedt een snelle en gemakkelijk te gebruiken en zeer schaalbare manier om websites te schrapen.

Voordat we dieper ingaan op de Scrapestack API , beginnen we met het bespreken van scraping. We zullen uitleggen wat het is en waarom het zo wijdverbreid wordt gebruikt op internet. En als we het over internet hebben, dan zullen we kijken naar het specifieke geval van webscraping, aangezien dit is waar de Scrapestack API voor is gemaakt en we zullen ook enkele van de belangrijkste redenen introduceren waarom iemand een derde partij zou gebruiken scraping API zoals deze. Nadat we kort hebben uitgelegd wat een REST API is, komen we eindelijk tot de kern van de zaak als we de Scrapestack API presenteren. We krijgen eerst een overzicht van het product voordat we enkele van zijn beste eigenschappen verder analyseren. We zullen volgen door te kijken hoe gemakkelijk het gebruik van de API is voordat we de meerlagige prijsstructuur van de service presenteren.

Schrapen in een notendop

Gegevensschrapen is het proces waarbij gegevens worden geëxtraheerd uit voor mensen leesbare uitvoer afkomstig van een ander programma of proces. Het verschilt op verschillende manieren van andere vormen van gegevensoverdracht. Gegevensoverdracht tussen programma's gebeurt meestal met behulp van gegevensstructuren die geschikt zijn voor geautomatiseerde verwerking door computers. Deze uitwisselingsformaten en protocollen zijn strak gestructureerd, goed gedocumenteerd, gemakkelijk te ontleden en houden dubbelzinnigheid tot een minimum beperkt. Deze uitzendingen zijn doorgaans helemaal niet door mensen leesbaar. Ze zijn ontworpen om efficiënt en snel te zijn. Het belangrijkste element dat gegevensschrapen onderscheidt van andere vormen van gegevensuitwisseling, is dat de uitvoer die wordt geschraapt normaal gesproken bedoeld is voor weergave aan een eindgebruiker, in plaats van als invoer voor een ander programma. Als zodanig is het daarom zelden gedocumenteerd of gestructureerd voor gemakkelijke ontleding.

Er zijn een paar redenen waarom men zijn toevlucht zou nemen tot gegevensschrapen. Het wordt bijvoorbeeld meestal gedaan om te communiceren met een legacy-systeem, een systeem dat geen ander mechanisme heeft dat compatibel is met huidige overdrachtsmechanismen. Het kan ook worden gebruikt om gegevens uit een systeem van derden te halen dat geen handigere API biedt. In dit laatste geval kan de eigenaar van het externe systeem het schrapen van gegevens als ongewenst beschouwen vanwege redenen zoals een verhoogde systeembelasting, het verlies van advertentie-inkomsten of het verlies van controle over de informatie-inhoud.

Hoe wijdverbreid het ook is geworden, het schrapen van gegevens wordt meestal beschouwd als een ad-hoc, onelegante techniek die vaak wordt gebruikt als laatste redmiddel wanneer er geen ander mechanisme voor gegevensuitwisseling beschikbaar is. Gegevensschrapen wordt vaak geassocieerd met een hogere programmeer- en verwerkingsoverhead, aangezien outputdisplays die bedoeld zijn voor menselijke consumptie vaak vaak van structuur veranderen. Hoewel mensen zich gemakkelijk kunnen aanpassen aan deze veranderingen, kan een computerprogramma dat niet, omdat het is verteld om gegevens in een specifiek formaat of vanaf een specifieke locatie te lezen zonder te weten hoe de resultaten op validiteit kunnen worden gecontroleerd.

Het specifieke geval van webscraping

Webscraping is gewoon een specifiek type datascraping dat wordt gebruikt om gegevens van webpagina's op te halen. Webpagina's worden, zoals u weet, gebouwd met op tekst gebaseerde opmaaktalen zoals HTML en XHTML. Ze zijn echter meestal ontworpen voor menselijke eindgebruikers en niet voor eenvoudig geautomatiseerd gebruik. Dit is de belangrijkste reden waarom webschrapers zoals de Scrapestack API zijn gemaakt. Een webschraper is een API of een tool die gegevens van een website haalt.

Aangezien organisaties over het algemeen zeer beschermend zijn voor hun gegevens, gebruiken grote websites meestal defensieve algoritmen om deze te beschermen tegen webschrapers. Ze kunnen bijvoorbeeld het aantal verzoeken dat een IP- of IP-netwerk kan verzenden, beperken. De beste tools voor webschrapen bevatten mechanismen om deze beveiligingen tegen te gaan.

Een scraping-API van derden gebruiken

Webscraping van een eenvoudige, statische webpagina is meestal vrij eenvoudig te implementeren. Helaas behoren eenvoudige, statische webpagina's tot een ver verleden en de meeste moderne websites nemen hun toevlucht tot verschillende technologieën om hun bezoekers dynamische inhoud te bieden. Dit is waar het gebruik van een tool van derden voordelig kan worden. Deze tools verwerken alle onderliggende details en verschijnen op de website die ze als gewone gebruiker proberen te schrapen. Sommigen gaan zelfs zo ver dat ze formulieren voor u invullen. Maar de beste reden waarom iemand een scraping-tool van derden zou gebruiken, zoals de Scrapestack API, is gemak. Het gebruik ervan maakt het gewoon veel gemakkelijker.

Wat is een REST-API?

Een API, wat staat voor Application Programming Interface, is een middel om het ene programma of proces vanuit een ander aan te roepen. Bovendien hoeft het aangeroepen proces niet eens op hetzelfde apparaat te draaien als de aangeroepen persoon. Wat betreft het REST-gedeelte, het is een beetje ingewikkelder. Laten we proberen het uit te leggen.

REST, wat staat voor REpresentational State Transfer, is een software-architectuurstijl die een reeks beperkingen schetst die moeten worden gebruikt voor het maken van webservices. Degenen die voldoen aan de REST-architectuurstijl worden RESTful-webservices genoemd en bieden interoperabiliteit tussen computersystemen op internet. Bovendien stellen ze de verzoekende systemen in staat om toegang te krijgen tot tekstuele representaties van verschillende webbronnen en deze te manipuleren door gebruik te maken van een uniforme en vooraf gedefinieerde reeks staatloze operaties.

In eenvoudiger bewoordingen is een REST API er een die gemakkelijk toegankelijk is met behulp van standaard webaanroepen zoals HTTP "get", "post", "put" en "delete" en die de gevraagde gegevens op een georganiseerde manier retourneren. In het specifieke geval van de Scrapestack API gebruikt het het populaire JSON-formaat. Resultaten kunnen daarom eenvoudig worden verwerkt met behulp van gangbare talen zoals Javascript. Andere tools kunnen andere formaten gebruiken, waarbij XML enorm populair is. De REST-specificatie schrijft alleen voor dat een vast, vooraf gedefinieerd formaat wordt gebruikt.

Introductie van de Scrapestack API

De Scrapestack-API is, je moet het bedacht hebben, een REST-API voor webscraping. In een notendop, de Scrapestack API kan elke webpagina omzetten in bruikbare gegevens. Het is een cloudgebaseerde API-service waarmee gebruikers websites kunnen schrapen zonder zich zorgen te hoeven maken over technische problemen zoals proxy's, IP-blokkeringen, geotargeting, CAPTCHA-oplossing en meer. Om het te gebruiken, geeft u het gewoon een geldige website-URL en binnen slechts enkele milliseconden zal de Scrapestack API de volledige HTML-inhoud van de site als antwoord retourneren. De inhoud die u krijgt, wordt weergegeven zoals deze in de browser wordt weergegeven, inclusief eventuele JavaScript-weergave in plaats van de daadwerkelijke code die deel uitmaakt van de webpagina. De tool wordt aangedreven door een van de krachtigste webscraping-engines op de markt en biedt een van de beste oplossingen voor al uw scraping-eisen.

De Scrapestack API is ontwikkeld en onderhouden door apilayer , een softwarebedrijf gevestigd in Londen, VK en Wenen, Oostenrijk. Het is hetzelfde bedrijf dat achter verschillende populaire API- en SaaS-producten wereldwijd zit, waaronder weatherstack, factuur en eversign. Deze krachtige infrastructuur wordt door meer dan 2000 organisaties wereldwijd gebruikt. Momenteel verwerkt de online service, die is gebouwd om miljoenen proxy-IP-adressen, browsers en CAPTCHA's te verwerken, meer dan een miljard verzoeken per maand en heeft het een indrukwekkende gemiddelde uptime van 99,9%. Dit zorgt ervoor dat de service beschikbaar is wanneer u deze nodig heeft.

Een rondleiding door de belangrijkste kenmerken van de Scrapestack API

Wat de functionaliteit betreft , laat de Scrapestack API niet veel te wensen over, ongeacht waarom u websites moet schrapen of welke gegevens u ook probeert te verkrijgen, het product is hoogstwaarschijnlijk zeer geschikt voor uw behoeften. Laten we kort enkele van de belangrijkste functies van deze tool bekijken.

Miljoenen proxy's en IP-adressen

Een van de manieren waarop websites zich beschermen tegen scraping, is door bron-IP-adressen te identificeren die meerdere, opeenvolgende verzoeken genereren. Om die reden moet een webscraping-tool zijn toevlucht nemen tot het gebruik van verschillende IP-adressen voor elk verzoek. De Scrapestack API lost dit op door een uitgebreide pool van meer dan vijfendertig miljoen datacenter- en residentiële proxy-IP-adressen aan te bieden, verspreid over tientallen wereldwijde internetserviceproviders, en door echte apparaten, slimme nieuwe pogingen en IP-rotatie te ondersteunen. Dit zorgt ervoor dat uw scrapverzoeken hoogstwaarschijnlijk onopgemerkt blijven bij de sites die worden geschraapt.

Het datacenter of "standaard" proxy's zijn de meest voorkomende. Ze zijn geen eigendom van een specifieke ISP en ze maskeren eenvoudigweg uw oorspronkelijke IP-adres door het IP-adres van de proxybron van het datacenter en de informatie te tonen die is gekoppeld aan het bedrijf dat eigenaar is van het respectievelijke datacenter.

Wat betreft de residentiële of "premium" proxy's, deze bieden IP-adressen die zijn verbonden met echte residentiële adressen en thuisapparaten. Dit maakt het veel minder waarschijnlijk dat ze worden geblokkeerd tijdens het schrapen van het web. Het gebruik van residentiële proxy's voor webscraping maakt het gemakkelijk om geografisch geblokkeerde inhoud te omzeilen en grote hoeveelheden gegevens te verzamelen.

Meer dan honderd wereldwijde locaties

Sommige websites retourneren verschillende informatie op basis van de locatie waar het verzoek vandaan komt. Evenzo accepteren sommige sites alleen verzoeken van bepaalde locaties. Een voorbeeld hiervan is een website als Netflix die alleen lokale inkomende verbindingen accepteert. De Amerikaanse Netflix is alleen toegankelijk vanaf in de VS gevestigde IP-adressen en de Canadese Netflix is alleen toegankelijk vanaf Canadese IP-adressen. Met de Scrapestack API kunt u kiezen uit meer dan honderd ondersteunde wereldwijde locaties om uw API-verzoeken voor webscraping te verzenden. Je hebt ook de mogelijkheid om willekeurige geografische doelen te gebruiken, ter ondersteuning van een reeks grote steden over de hele wereld.

Rotsvaste infrastructuur

Een cloudgebaseerde service zoals de Scrapestack API is zo goed als de infrastructuur waarop deze is gebouwd. Daarom is dit een ijzersterke service met een indrukwekkende uptime. Met behulp van de service kunt u het web met een ongeëvenaarde snelheid schrapen. U profiteert ook van een groot aantal geavanceerde functies, zoals gelijktijdige API-verzoeken, CAPTCHA-oplossing, browserondersteuning en JS-rendering. De service is bovenop de apilayer- cloudinfrastructuur gebouwd. Dit maakt de service zeer schaalbaar en in staat om alles te verwerken, van slechts duizenden API-verzoeken per maand tot miljoenen per dag. Het wordt aangedreven door een systeem dat naar behoefte op- en afschaalt en het kan de hoogst mogelijke responstijd bieden voor elk API-verzoek op elk gebruiksniveau.

De Scrapestack-API gebruiken

Het gebruik van de Scrapestack API is zo eenvoudig als het maar zijn kan. De eerste stap is natuurlijk het aanmaken van een account. Als u deze maakt, wordt uw unieke API-toegangssleutel onthuld die u bij elk verzoek moet gebruiken om te verifiëren met de API. U doet dat door simpelweg de parameter access_key toe te voegen aan de basis-URL van de API en deze in te stellen op uw API-toegangssleutel.

https://api.scrapestack.com/scrape ? access_key = UW_ACCESS_KEY

De betaalde abonnementen ondersteunen 256-bit HTTPS-codering. Om het te gebruiken, hoef je alleen maar HTTPS te gebruiken in plaats van HTTP in je API-aanroepen.

Het meest elementaire type verzoek wordt terecht een "basis" verzoek genoemd. In de meest elementaire vorm hoeft u alleen uw API-toegangssleutel en de URL van de pagina die u wilt schrapen op te geven. Als u bijvoorbeeld de https://apple.com-pagina wilt schrapen, ziet het verzoek er als volgt uit:

https://api.scrapestack.com/scrape ? access_key = UW_ACCESS_KEY & url = https://apple.com

Merk op dat er verschillende optionele parameters zijn die aan uw verzoeken kunnen worden toegevoegd. We zullen een aantal van deze in meer detail in een ogenblik bespreken.

Na een succesvolle uitvoering reageert de API met de onbewerkte HTML-gegevens van de URL van uw doelwebpagina. Dit is hoe een typisch antwoord op een basisverzoek eruitziet. Merk op dat het voor de leesbaarheid is ingekort. Een daadwerkelijke reactie zou alle code binnen de bevatten

en

secties.

[...] // 44 regels overgeslagen [...] // 394 regels overgeslagen

Optionele parameters:

De eerste en meest gebruikte optionele parameter is zeker de JavaScript Rendering . Het is beschikbaar op alle betaalde abonnementen. Zoals u weet, geven sommige webpagina's essentiële pagina-elementen weer met JavaScript. Dit betekent dat sommige inhoud niet aanwezig is - en daarom niet kan worden geschraapt - bij het aanvankelijk laden van de pagina. Als de parameter render_js is ingeschakeld, heeft de Scrapestack-API toegang tot het doelweb met behulp van een headless browser (Google Chrome) en kunnen JavaScript-pagina-elementen worden weergegeven voordat het uiteindelijke scraping-resultaat wordt geleverd. Het inschakelen van deze optie is een kwestie van de parameter render_js toevoegen aan uw API-verzoek-URL en deze instellen op 1.

https://api.scrapestack.com/scrape ? access_key = UW_ACCESS_KEY & url = https://apple.com & render_js = 1

Een andere handige optionele parameter is de mogelijkheid om Proxy Locations op te geven , ook beschikbaar op alle betaalde abonnementen. De Scrapestack API gebruikt een pool van meer dan 35 miljoen IP-adressen wereldwijd. Standaard worden IP-adressen automatisch geroteerd, zodat hetzelfde IP-adres nooit twee keer achter elkaar wordt gebruikt. Met behulp van de optionele parameter proxy_location van de API kunt u een specifiek land kiezen door de 2-letterige landcode op te geven. In het onderstaande voorbeeld wordt bijvoorbeeld au (Australië) gespecificeerd als een proxylocatie. De zoekopdracht wordt dus uitgevoerd vanaf een in Australië gevestigd IP-adres.

https://api.scrapestack.com/scrape ? access_key = UW_ACCESS_KEY & url = https://apple.com & proxy_location = au

De Premium Proxy's is een andere interessante optie. Dit is hoe het werkt. Standaard gebruikt de Scrapestack API altijd standaard (datacenter)proxy's voor scraping-verzoeken. En hoewel dit de meest voorkomende proxy's zijn die op internet worden gebruikt, is de kans groter dat ze worden geblokkeerd wanneer ze proberen gegevens te schrapen.

Als u zich abonneert op het Professional Plan of hoger, geeft de Scrapestack API toegang tot premium (residentiële) proxy's. Die worden geassocieerd met echte woonadressen en daarom is het veel minder waarschijnlijk dat ze worden geblokkeerd tijdens het schrapen van gegevens op internet. Net als andere optionele parameters, is het gebruik van deze optie slechts een kwestie van het toevoegen van de premium_proxy-parameter aan uw scraping-verzoek en deze in te stellen op 1.

https://api.scrapestack.com/scrape ? access_key = UW_ACCESS_KEY & url = https://apple.com & premium_proxy = 1

Hoewel we nog een hele tijd door kunnen gaan met het bespreken van de vele opties die beschikbaar zijn met de Scrapestack API , is ons doel om het product te beoordelen, niet om er een handleiding voor te schrijven. Bovendien heeft de Scrapestack- website zeer grondige documentatie en zou het uw primaire bron van praktische informatie moeten zijn.

Prijsinformatie

De Scrapestack API- service is beschikbaar onder verschillende tariefplannen. Op het laagste niveau biedt het gratis abonnement een manier om vertrouwd te raken met de API. Het heeft basis API-functionaliteit en een limiet van 10.000 API-verzoeken per maand. Als u meer zoekopdrachten moet uitvoeren of een geavanceerdere set functies nodig heeft, zoals gelijktijdige verzoeken of premium proxytoegang, kunt u kiezen uit een van de beschikbare betaalde abonnementen.

Aangezien de meeste betaalde abonnementen een vergelijkbare functieset bieden, is de beslissende factor als het gaat om uw technische vereisten vaak het aantal API-verzoeken dat u maandelijks moet doen. Betalingen kunnen worden gedaan met creditcard of PayPal. Bovendien kunnen zakelijke en grote klanten verzoeken om jaarlijkse bankoverschrijvingen in te schakelen. En over jaarlijkse betaling gesproken, als u voor deze optie kiest, krijgt u 20% korting ten opzichte van de maandelijkse betalingen, waardoor het product nog voordeliger wordt. En als u niet zeker bent van de factureringsfrequentie, houd er dan rekening mee dat u (relatief) eenvoudig kunt overschakelen van maandelijks naar jaarlijks en terug. Het houdt echter in dat u eerst moet downgraden naar het gratis abonnement en onmiddellijk moet upgraden naar een betaald abonnement.

Bottom Line

Hoe eenvoudig of hoe complex uw behoefte aan webscraping ook is, de Scrapestack API kan u hoogstwaarschijnlijk helpen uw doelen eenvoudig en moeiteloos te bereiken. Met indrukwekkende betrouwbaarheid en schaalbaarheid. Deze cloudgebaseerde service past zich feilloos aan bijna elke situatie aan. Het heeft alle opties die je nodig hebt en het biedt de middelen om je scraping-pogingen achter miljoenen proxy-IP-adressen te vervalsen.

Twijfel je nog of de Scrapestack API iets voor jou is? Maak gebruik van het beschikbare gratis abonnement en probeer de service uit. Ik ben er vrij zeker van dat je net als ik versteld zult staan van de algehele bruikbaarheid en prestaties.

Los de fout ERR_TUNNEL_CONNECTION_FAILED in Chrome op met deze bewezen oplossingen. Ontdek de oorzaken en hoe u deze snel kunt oplossen.

Iets wat ik absoluut geweldig vind aan Firefox en waar ik me in Chrome constant aan erger, is hoe ik de extensies open. In Firefox kan ik...

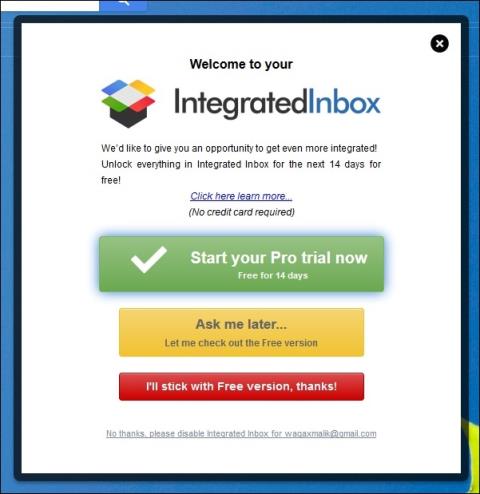

We weten dat alle Google-diensten zoals Gmail, Agenda, Maps, Google Drive etc. gezamenlijk Google Apps heten. De zoekgigant heeft geïntegreerd

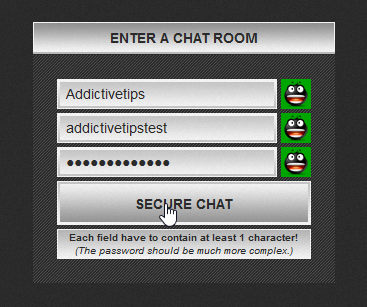

Gebruik ChatCrypt voor veilige, versleutelde berichten die je gesprekken privé houden. Een gebruiksvriendelijk platform, ontworpen voor vertrouwelijke communicatie, altijd en overal.

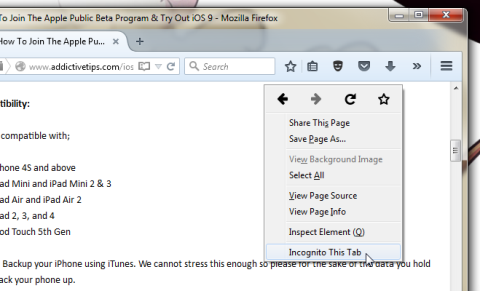

Ruim twee jaar geleden vond ik een Firefox-add-on waarvan ik dacht dat het een puur maar eenvoudig meesterwerk was. De add-on in kwestie heet Private Tab en het is een

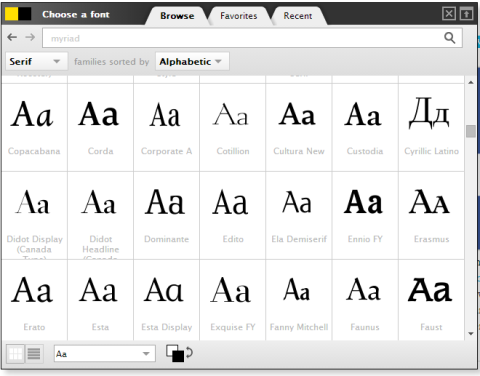

WebFonter is een Chrome-extensie en bookmarklet waarmee u lettertypen kunt uitproberen in de FontShop. Deze bevat een grote collectie lettertypen die u kunt kopen.

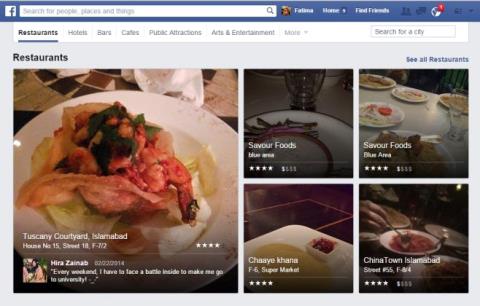

Het aantal apps dat is ontwikkeld om mensen te helpen interessante dingen te vinden om te doen, mensen te vinden om dingen mee te doen, of gewoon een goede plek om te eten te vinden, is enorm en

Geef je onnodig geld uit aan het kopen van spullen op Amazon, om er vervolgens achter te komen dat je portemonnee leeg is wanneer je het het hardst nodig hebt? Hoe weinig of hoeveel geld je ook hebt,

Leer hoe u site-instellingen in uw browser kunt openen en beheren. Beheer machtigingen voor locatie, camera, microfoon en meer in Chrome.

Vind de beste proxywebbrowser voor anoniem browsen, verbeterde beveiliging en naadloos proxybeheer. Ontdek nu de beste opties!

![Met Agora kunt u producten vergelijken wanneer u online artikelen koopt [Chrome] Met Agora kunt u producten vergelijken wanneer u online artikelen koopt [Chrome]](https://tips.webtech360.com/resources8/r252/image-5055-0829094639067.jpg)