Toate remediile pentru eroarea ERR_TUNNEL_CONNECTION_FAILED

Remediați eroarea ERR_TUNNEL_CONNECTION_FAILED din Chrome cu aceste soluții dovedite. Aflați cauzele și cum să le rezolvați rapid.

Web scraping poate părea simplă, dar de fapt se poate dovedi a fi un efort destul de complex. Mulți proprietari de site-uri încearcă să se protejeze în mod activ împotriva acesteia pentru a-și proteja datele, ceea ce împiedică în mare parte rularea unui script intern pentru a extrage în mod repetat date de pe site-urile web țintă. Pentru o scraping eficientă, aveți nevoie de un instrument specializat, cum ar fi API-ul Scrapestack, pe care urmează să-l revizuim. Folosind-o, puteți să răzuiți rapid și eficient aproape orice site web și să extrageți informațiile pe care le conține și să le folosiți. Scrapestack oferă un mod rapid și ușor de utilizat și foarte scalabil de a răzui site-uri web.

Înainte de a intra în mai multe detalii despre API-ul Scrapestack , vom începe prin a discuta despre scraping. Vom explica ce este și de ce este utilizat atât de răspândit pe internet. Și vorbind despre Internet, vom arunca o privire asupra cazului specific al scraping-ului web, deoarece pentru asta este creat API-ul Scrapestack și vom introduce, de asemenea, câteva dintre cele mai importante motive pentru care oricine ar folosi o terță parte. scraping API precum acesta. După ce am explicat pe scurt ce este un API REST, vom ajunge în sfârșit la miezul problemei în timp ce prezentăm API-ul Scrapestack. Vom avea mai întâi o prezentare generală a produsului înainte de a analiza în continuare unele dintre cele mai bune caracteristici ale acestuia. Vom urma să aruncăm o privire asupra cât de ușoară este utilizarea API-ului înainte de a prezenta structura de prețuri pe mai multe niveluri a serviciului.

Razuire pe scurt

Data scraping este procesul de extragere a datelor din rezultate care pot fi citite de om provenind dintr-un alt program sau proces. Este diferit de alte forme de transfer de date în mai multe moduri. Transferul de date între programe se face de obicei folosind structuri de date potrivite pentru procesarea automată de către computere. Aceste formate și protocoale de schimb sunt structurate rigid, bine documentate, ușor de analizat și mențin ambiguitatea la minimum. Aceste transmisii nu sunt de obicei citite de om. Sunt concepute pentru a fi eficiente și rapide. Elementul principal care diferențiază data scraping de alte forme de schimb de date este că rezultatul care este răzuit este destinat în mod normal pentru a fi afișat către un utilizator final, mai degrabă decât ca intrare într-un alt program. Ca atare, este rar documentat sau structurat pentru o analiză convenabilă.

Există câteva motive pentru care s-ar recurge la data scraping. De exemplu, cel mai adesea se face fie pentru a interfața cu un sistem moștenit, unul care nu are niciun alt mecanism compatibil cu mecanismele de transfer curente. De asemenea, ar putea fi folosit pentru a extrage date dintr-un sistem terță parte care nu oferă un API mai convenabil. În acest ultim caz, proprietarul sistemului terță parte poate vedea scraping-ul de date ca nedorit din motive precum încărcarea crescută a sistemului, pierderea veniturilor din reclamă sau pierderea controlului asupra conținutului informațional.

Pe cât de răspândită a devenit, data scraping este de obicei considerată o tehnică ad-hoc, inelegantă, care este adesea folosită ca ultimă soluție atunci când nu este disponibil niciun alt mecanism de schimb de date. Scraping-ul de date este adesea asociat cu o suprasarcină mai mare de programare și procesare, deoarece afișajele de ieșire destinate consumului uman își schimbă adesea structura frecvent. În timp ce oamenii se pot adapta cu ușurință la aceste schimbări, un program de calculator s-ar putea să nu, după ce i s-a spus să citească datele într-un anumit format sau dintr-o locație specifică, fără cunoștințe despre cum să verifice validitatea rezultatelor.

Cazul specific al web scraping

Web scraping este pur și simplu un tip specific de date scraping care este utilizat pentru a prelua date de pe paginile web. După cum știți, paginile web sunt construite folosind limbaje de marcare bazate pe text, cum ar fi HTML și XHTML. Ele sunt, totuși, de obicei concepute pentru utilizatorii finali umani și nu pentru ușurința utilizării automate. Acesta este principalul motiv pentru care au fost create scraper-uri web, cum ar fi API-ul Scrapestack . Un web scraper este un API sau un instrument care extrage date de pe un site web.

Deoarece organizațiile tind să fie foarte protectoare cu datele lor, site-urile web majore folosesc de obicei algoritmi defensivi pentru a le proteja de scraper-urile web. Ele pot, de exemplu, să limiteze numărul de solicitări pe care o rețea IP sau IP le poate trimite. Cele mai bune instrumente de web scraping includ mecanisme pentru a contracara aceste protecții.

Utilizarea unui API Scraping terță parte

Scrapingul web dintr-o pagină web simplă, statică tinde să fie destul de ușor de implementat. Din păcate, paginile web simple, statice, aparțin unui trecut îndepărtat, iar majoritatea site-urilor web moderne recurg la diverse tehnologii pentru a oferi conținut dinamic vizitatorilor lor. Aici poate deveni avantajoasă utilizarea unui instrument terță parte. Aceste instrumente se vor ocupa de toate detaliile de bază și vor apărea pe site-ul web pe care încearcă să îl trimită ca utilizator obișnuit. Unii vor merge chiar și până la completarea formularelor pentru tine. Dar cel mai bun motiv pentru care oricine ar folosi un instrument de răzuire terță parte, cum ar fi API-ul Scrapestack, este comoditatea. Folosirea lui pur și simplu face lucrurile mult mai ușoare.

Ce este un API REST?

Un API, care înseamnă interfața de programare a aplicației, este un mijloc de a apela un program sau un proces de la altul. În plus, procesul apelat nici măcar nu trebuie să ruleze pe același dispozitiv cu cel apelat. În ceea ce privește partea REST, este puțin mai complicată. Să încercăm să explicăm.

REST, care înseamnă REpresentational State Transfer, este un stil arhitectural software care conturează un set de constrângeri care trebuie utilizate pentru crearea de servicii web. Cele care se conformează stilului arhitectural REST se numesc servicii web RESTful și oferă interoperabilitate între sistemele informatice de pe Internet. Mai mult, ele permit sistemelor solicitante să acceseze și să manipuleze reprezentări textuale ale diferitelor resurse web prin utilizarea unui set uniform și predefinit de operațiuni fără stat.

În termeni mai simpli, o API REST este una care poate fi accesată cu ușurință folosind apeluri web standard, cum ar fi HTTP „get”, „post”, „put” și „delete” și care returnează datele solicitate într-un mod organizat. În cazul specific al API-ului Scrapestack , acesta utilizează formatul popular JSON. Rezultatele pot fi procesate cu ușurință folosind limbaje comune, cum ar fi Javascript. Alte instrumente pot folosi alte formate, XML fiind extrem de popular. Specificația REST impune doar utilizarea unui format fix, predefinit.

Vă prezentăm API-ul Scrapestack

Scrapestack API - ul este, trebuie să fi dat seama, un API REST pentru răzuire web. Pe scurt, API-ul Scrapestack poate transforma orice pagină web în date acționabile. Este un serviciu API bazat pe cloud, care permite utilizatorilor săi să analizeze site-uri web fără a fi nevoiți să-și facă griji cu privire la probleme tehnice, cum ar fi proxy-uri, blocări IP, direcționare geografică, rezolvare CAPTCHA și multe altele. Pentru a-l folosi, trebuie doar să îi oferiți o adresă URL validă a site-ului și, în doar câteva milisecunde, API-ul Scrapestack va returna conținutul HTML complet al site-ului ca răspuns. Conținutul pe care îl obțineți va apărea așa cum se vede în browser, inclusiv orice redare JavaScript, mai degrabă decât codul real care face parte din pagina web. Instrumentul este alimentat de unul dintre cele mai puternice motoare de scraping web de pe piață și oferă una dintre cele mai bune soluții pentru toate cerințele dvs. de scraping.

Scrapestack API - ul este dezvoltat și întreținut de apilayer , o companie de software cu sediul in Londra, Marea Britanie și Viena, Austria. Este aceeași companie care se află în spatele mai multor produse API și SaaS populare la nivel mondial, inclusiv weatherstack, invoicely și eversign. Această infrastructură puternică este utilizată de peste 2000 de organizații din întreaga lume. În prezent, serviciul online, care este construit pentru a procesa milioane de adrese IP proxy, browsere și CAPTCHA, gestionează peste un miliard de solicitări în fiecare lună și se mândrește cu un timp de funcționare mediu impresionant de 99,9%. Acest lucru vă asigură că serviciul va fi disponibil atunci când aveți nevoie de el.

Un tur al principalelor caracteristici ale API-ului Scrapestack

În ceea ce privește caracteristicile, API-ul Scrapestack nu lasă mult de dorit, indiferent de ce trebuie să răzuiți site-uri web sau ce date încercați să obțineți, produsul este cel mai probabil potrivit pentru nevoile dvs. Să explorăm pe scurt câteva dintre cele mai importante caracteristici ale acestui instrument.

Milioane de proxy și adrese IP

Una dintre modalitățile prin care site-urile web se protejează împotriva scrapingului este identificarea adreselor IP sursă care generează solicitări multiple, succesive. Din acest motiv, un instrument de scraping web trebuie să recurgă la utilizarea diferitelor adrese IP pentru fiecare solicitare. Cele Scrapestack API abordează acest oferind o piscină largă de centru de peste treizeci la cinci milioane de date și adrese IP aproximat rezidențiale în zeci de furnizori de servicii de internet la nivel mondial precum și prin sprijinirea dispozitive reale, reíncercări inteligente și de rotație IP. Acest lucru vă asigură că solicitările dvs. de scraping vor trece cel mai probabil neobservate pe site-urile care sunt răzuite.

Centrul de date sau proxy-urile „standard” sunt cele mai comune. Ele nu sunt deținute de un anumit ISP și pur și simplu maschează adresa IP de origine afișând adresa IP sursă proxy a centrului de date și informațiile asociate cu compania care deține centrul de date respectiv.

În ceea ce privește proxy-urile rezidențiale sau „premium”, aceștia oferă adrese IP care sunt conectate la adrese rezidențiale reale și la dispozitive de acasă. Acest lucru îi face mult mai puțin probabil să fie blocați în timp ce răzuiesc web-ul. Utilizarea proxy-urilor rezidențiale pentru web scraping facilitează rezolvarea conținutului geo-blocat și colectarea unor cantități mari de date.

Peste o sută de locații globale

Unele site-uri web vor returna informații diferite în funcție de locația din care provine solicitarea. De asemenea, unele site-uri vor accepta cereri doar din anumite locații. Un astfel de exemplu este un site web precum Netflix, care va accepta doar conexiuni locale de intrare. Netflix-ul american poate fi accesat numai de la adrese IP din SUA, iar Netflix-ul canadian poate fi accesat numai de la adrese IP canadiene. Scrapestack API poate permite să alege din peste o sută de locații la nivel mondial sprijinite pentru a trimite web răzuire solicitărilor API. Aveți, de asemenea, opțiunea de a utiliza ținte geografice aleatorii, susținând o serie de orașe majore din întreaga lume.

Infrastructură solidă

Un serviciu bazat pe cloud, cum ar fi API-ul Scrapestack, este la fel de bun ca infrastructura pe care este construit. În acest sens, acesta este un serviciu solid, cu un timp de funcționare impresionant. Utilizarea serviciului vă permite să răzuiați web-ul cu o viteză inegalabilă. Veți beneficia, de asemenea, de o mulțime de funcții avansate, cum ar fi solicitări API concurente, rezolvarea CAPTCHA, suport pentru browser și redarea JS. Serviciul este construit pe deasupra infrastructurii cloud apilayer . Acest lucru face ca serviciul să fie extrem de scalabil și capabil să gestioneze orice, de la doar mii de solicitări API pe lună până la milioane pe zi. Este alimentat de un sistem care crește și scade după cum este necesar și poate oferi cel mai mare timp de răspuns posibil pentru orice solicitare API la orice nivel de utilizare.

Utilizarea API-ului Scrapestack

Utilizarea API-ului Scrapestack este cât se poate de ușoară. Primul pas, desigur, este să creați un cont. Crearea acestuia va dezvălui cheia dvs. unică de acces API pe care trebuie să o utilizați la fiecare solicitare pentru a vă autentifica cu API. Faceți asta prin simpla adăugare a parametrului access_key la adresa URL de bază a API-ului și setându-l la cheia dvs. de acces API.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY

Planurile plătite acceptă criptarea HTTPS pe 256 de biți. Pentru a-l folosi, tot ce trebuie să faci este să folosești HTTPS în loc de HTTP în apelurile API.

Cel mai elementar tip de cerere este denumit în mod adecvat cerere „de bază”. În forma sa cea mai elementară, trebuie pur și simplu să specificați cheia de acces API și adresa URL a paginii pe care doriți să o eliminați. De exemplu, pentru a răzui pagina https://apple.com, cererea ar arăta astfel:

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY și url = https://apple.com

Rețineți că există câțiva parametri opționali care pot fi adăugați la solicitările dvs. Vom discuta unele dintre acestea în detaliu într-un moment.

După executarea cu succes, API-ul răspunde cu datele HTML brute ale adresei URL a paginii web țintă. Iată cum arată un răspuns tipic de la o solicitare de bază. Rețineți că a fost scurtat din motive de lizibilitate. Un răspuns real ar include tot codul din

și

secțiuni.

[...] // 44 de linii sărite [...] // 394 de rânduri sărite

Parametri opționali

Primul și cel mai folosit parametru opțional este cu siguranță redarea JavaScript . Este disponibil pentru toate planurile plătite. După cum știți, unele pagini web redă elemente esențiale ale paginii folosind JavaScript. Aceasta înseamnă că un anumit conținut nu este prezent și, prin urmare, nu poate fi răzuit la încărcarea inițială a paginii. Cu parametrul render_js activat, API-ul Scrapestack va accesa web-ul țintă utilizând un browser headless (Google Chrome) și va permite elementelor paginii JavaScript să fie redate înainte de a furniza rezultatul final al scraping-ului. Activarea acestei opțiuni este o chestiune simplă de a adăuga parametrul render_js la adresa URL a solicitării API și de a-l seta la 1.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & render_js = 1

Un alt parametru opțional util este capacitatea de a specifica Locații proxy , disponibilă și pentru toate planurile plătite. Scrapestack API - ul folosește un bazin de peste 35 de milioane de adrese IP la nivel mondial. În mod implicit, va roti automat adresele IP astfel încât aceeași adresă IP să nu fie folosită niciodată de două ori la rând. Folosind parametrul opțional proxy_location din API, puteți alege o anumită țară, indicând codul său de țară din două litere. De exemplu, exemplul de mai jos specifică au (Australia) ca locație proxy. Interogarea va fi astfel rulată de la o adresă IP din Australia.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & proxy_location = au

Premium Proxies este o altă opțiune interesantă. Iată cum funcționează. În mod implicit, API-ul Scrapestack utilizează întotdeauna proxy-uri standard (centre de date) pentru solicitările de scraping. Și, deși sunt cele mai frecvente proxy-uri utilizate pe internet, este, de asemenea, mult mai probabil să se blocheze atunci când încearcă să răzuiască date.

Dacă vă abonați la Planul profesional sau o versiune superioară, API-ul Scrapestack vă permite accesul la proxy-uri premium (rezidențiale). Acestea sunt asociate cu adrese rezidențiale reale și, prin urmare, sunt mult mai puțin probabil să fie blocate în timp ce răzuiesc datele de pe web. Ca și alți parametri opționali, utilizarea acestei opțiuni este doar o chestiune de a adăuga parametrul premium_proxy la cererea dvs. de scraping și de a-l seta la 1.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & premium_proxy = 1

Deși am putea continua o perioadă de timp acoperind numeroasele opțiuni disponibile cu API-ul Scrapestack , scopul nostru este să revizuim produsul, nu să scriem un manual pentru acesta. În plus, site-ul web Scrapestack are o documentație foarte amănunțită și ar trebui să fie sursa ta principală de informații despre cum să faci.

Informații despre prețuri

Serviciul Scrapestack API este disponibil în mai multe planuri de prețuri. La cel mai de jos nivel, Planul gratuit oferă o modalitate de a vă familiariza cu API-ul. Are funcționalitate de bază API și o limitare de 10 000 de solicitări API pe lună. Dacă aveți nevoie să executați mai multe interogări sau aveți nevoie de un set mai avansat de funcții, cum ar fi solicitări concomitente sau acces proxy premium, puteți alege dintre planurile plătite disponibile.

Cu majoritatea planurilor plătite care oferă un set de caracteristici similare, factorul decisiv atunci când vine vorba de cerințele dumneavoastră tehnice va fi adesea numărul de solicitări API pe care trebuie să le faceți lunar. Plățile se pot face prin card de credit sau PayPal. În plus, clienții întreprinderi și cu volum mare pot solicita activarea plăților anuale prin transfer bancar. Și vorbind despre plata anuală, alegerea acestei opțiuni îți dă dreptul la o reducere de 20% față de plățile lunare, făcând produsul și mai accesibil. Și dacă nu sunteți sigur de frecvența de facturare, rețineți că puteți trece (relativ) cu ușurință de la lunar la anual și înapoi. Cu toate acestea, implică mai întâi trecerea la un plan gratuit și trecerea imediată la un plan plătit.

Concluzie

Indiferent cât de simplă sau cât de complexă ar fi nevoia dvs. de web scraping, API-ul Scrapestack vă poate ajuta cel mai probabil să vă atingeți obiectivele simplu și fără efort. Cu fiabilitate și scalabilitate impresionante. Acest serviciu bazat pe cloud se va adapta perfect la aproape orice situație. Are toate opțiunile de care ar putea avea nevoie și oferă mijloacele de a vă falsifica încercările de scraping în spatele milioanelor de adrese IP proxy.

Încă nu ești sigur dacă API-ul Scrapestack este potrivit pentru tine? De ce nu profitați de planul gratuit disponibil și oferiți serviciului o perioadă de probă. Sunt destul de sigur că veți fi pur și simplu uimiți, așa cum sunt și eu, de utilitatea și performanța sa generală.

Remediați eroarea ERR_TUNNEL_CONNECTION_FAILED din Chrome cu aceste soluții dovedite. Aflați cauzele și cum să le rezolvați rapid.

Ceva ce mă deranjează enorm la Firefox și care mă deranjează constant în Chrome este modul în care accesez extensiile. În Firefox, pot apăsa

Știm că toate serviciile Google precum Gmail, Calendar, Maps, Google Drive etc. sunt denumite colectiv Google Apps. Gigantul căutării a integrat

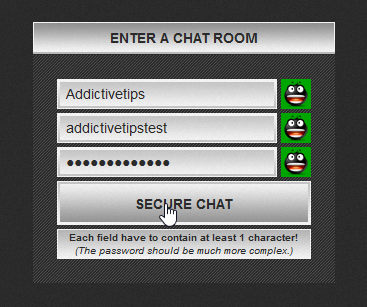

Folosește ChatCrypt pentru mesagerie securizată și criptată, care îți păstrează conversațiile private. Platformă ușor de utilizat, concepută pentru comunicare confidențială oricând și oriunde.

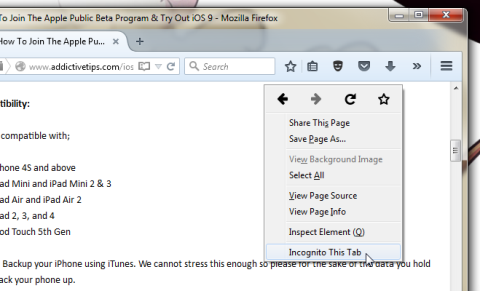

Acum doi ani buni am găsit un add-on pentru Firefox pe care l-am considerat o operă de geniu pură, dar simplă. Add-on-ul în cauză se numește Private Tab și...

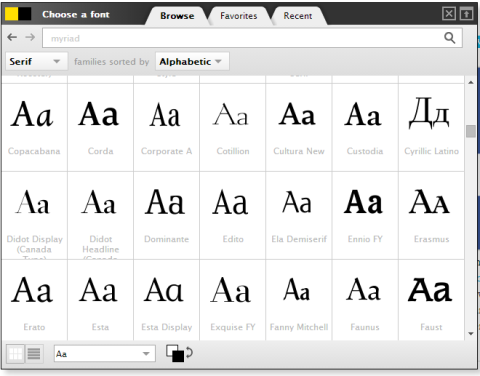

WebFonter este o extensie Chrome și un bookmarklet care vă permite să încercați fonturi din FontShop, care oferă o colecție mare de fonturi pe care le puteți cumpăra.

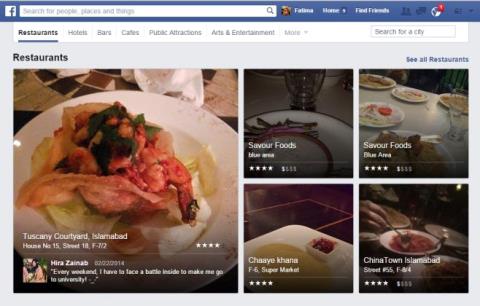

Numărul de aplicații dezvoltate pentru a ajuta oamenii să găsească lucruri interesante de făcut, oameni cu care să facă diverse lucruri sau pur și simplu un loc bun unde să mănânce este imens și

Cheltuiești bani inutil cumpărând lucruri pe Amazon doar ca să-ți dai seama că portofelul este gol când ai cea mai mare nevoie de el? Indiferent cât de puțini sau câți bani ai...

Află cum să accesezi și să gestionezi setările site-ului în browser. Controlează permisiunile pentru locație, cameră, microfon și multe altele în Chrome.

Găsește cel mai bun browser web proxy pentru navigare anonimă, securitate îmbunătățită și gestionare perfectă a proxy-ului. Explorează acum opțiunile de top!

![Agora îți permite să compari produse atunci când cumperi articole online [Chrome] Agora îți permite să compari produse atunci când cumperi articole online [Chrome]](https://tips.webtech360.com/resources8/r252/image-5055-0829094639067.jpg)