Ogni correzione per lerrore ERR_TUNNEL_CONNECTION_FAILED

Correggi l'errore ERR_TUNNEL_CONNECTION_FAILED in Chrome con queste soluzioni comprovate. Scopri le cause e come risolverle rapidamente.

Il web scraping può sembrare semplice, ma in realtà può rivelarsi un'impresa piuttosto complessa. Molti proprietari di siti Web cercano di proteggersi attivamente al fine di proteggere i propri dati, il che preclude principalmente l'esecuzione di uno script interno per estrarre ripetutamente i dati dai siti Web di destinazione. Per uno scraping efficiente, ciò di cui hai bisogno è uno strumento specializzato come l' API Scrapestack che stiamo per esaminare. Usandolo, puoi raschiare in modo rapido ed efficiente quasi tutti i siti Web ed estrarre le informazioni in esso contenute e metterle a frutto. Scrapestack fornisce un modo rapido, facile da usare e altamente scalabile per raschiare siti web.

Prima di entrare più in dettaglio sull'API Scrapestack , inizieremo discutendo dello scraping. Spiegheremo cos'è e perché è così diffuso in Internet. E parlando di Internet, daremo quindi un'occhiata al caso specifico del web scraping poiché questo è ciò per cui è fatta l' API Scrapestack e introdurremo anche alcuni dei motivi più importanti per cui qualcuno dovrebbe utilizzare una terza parte API di scraping come questa. Dopo aver brevemente spiegato cos'è un'API REST, arriveremo finalmente al nocciolo della questione presentando l' API Scrapestack. Daremo prima una panoramica del prodotto prima di analizzare ulteriormente alcune delle sue migliori caratteristiche. Seguiremo dando un'occhiata a quanto sia facile utilizzare l'API prima di presentare la struttura dei prezzi a più livelli del servizio.

Raschiare in poche parole

Lo scraping dei dati è il processo di estrazione dei dati da un output leggibile dall'uomo proveniente da un altro programma o processo. È diverso da altre forme di trasferimento di dati in diversi modi. Il trasferimento dei dati tra i programmi viene solitamente effettuato utilizzando strutture di dati adatte all'elaborazione automatizzata da parte dei computer. Questi formati e protocolli di interscambio sono rigidamente strutturati, ben documentati, facilmente analizzabili e riducono al minimo l'ambiguità. Queste trasmissioni non sono in genere affatto leggibili dall'uomo. Sono progettati per essere efficienti e veloci. L'elemento principale che distingue lo scraping dei dati da altre forme di scambio di dati è che l'output che viene raschiato è normalmente destinato alla visualizzazione per un utente finale, piuttosto che come input a un altro programma. In quanto tale, è quindi raramente documentato o strutturato per un'analisi conveniente.

Ci sono alcuni motivi per cui si ricorre allo scraping dei dati. Ad esempio, il più delle volte viene eseguito per interfacciarsi a un sistema legacy, uno che non ha altri meccanismi compatibili con gli attuali meccanismi di trasferimento. Potrebbe anche essere utilizzato per estrarre dati da un sistema di terze parti che non fornisce un'API più conveniente. In quest'ultimo caso, il proprietario del sistema di terze parti può vedere lo scraping dei dati come indesiderato a causa di motivi quali l'aumento del carico del sistema, la perdita di entrate pubblicitarie o la perdita di controllo del contenuto delle informazioni.

Per quanto diffuso, lo scraping dei dati è generalmente considerato una tecnica ad hoc e poco elegante che viene spesso utilizzata come ultima risorsa quando non sono disponibili altri meccanismi per lo scambio di dati. Lo scraping dei dati è spesso associato a un sovraccarico di programmazione ed elaborazione più elevato, poiché i display di output destinati al consumo umano cambiano spesso struttura di frequente. Mentre gli esseri umani possono adattarsi facilmente a questi cambiamenti, un programma per computer potrebbe non farlo, poiché gli è stato detto di leggere i dati in un formato specifico o da un luogo specifico senza sapere come verificare la validità dei risultati.

Il caso specifico del web scraping

Il web scraping è semplicemente un tipo specifico di data scraping che viene utilizzato per recuperare i dati dalle pagine web. Le pagine Web, come sai, sono costruite utilizzando linguaggi di markup basati su testo come HTML e XHTML. Tuttavia, sono generalmente progettati per utenti finali umani e non per facilità di utilizzo automatizzato. Questo è il motivo principale per cui sono stati creati i web scraper come l' API Scrapestack . Un web scraper è un'API o uno strumento che estrae i dati da un sito web.

Poiché le organizzazioni tendono ad essere molto protettive nei confronti dei propri dati, i principali siti Web di solito utilizzano algoritmi difensivi per proteggerli dai web scraper. Possono, ad esempio, limitare il numero di richieste che un IP o una rete IP può inviare. I migliori strumenti di web scraping includono meccanismi per contrastare queste protezioni.

Utilizzo di un'API di scraping di terze parti

Il web scraping da una semplice pagina web statica tende ad essere piuttosto facile da implementare. Sfortunatamente, le pagine Web semplici e statiche appartengono a un lontano passato e i siti Web più moderni ricorrono a varie tecnologie per fornire contenuti dinamici ai propri visitatori. È qui che l'utilizzo di uno strumento di terze parti può diventare vantaggioso. Questi strumenti gestiranno tutti i dettagli sottostanti e appariranno al sito Web che stanno cercando di raschiare come un utente normale. Alcuni arriveranno persino a compilare moduli per te. Ma il motivo migliore per cui qualcuno dovrebbe utilizzare uno strumento di scraping di terze parti come l' API Scrapestack è la comodità. Usarlo rende semplicemente le cose molto più facili.

Che cos'è un'API REST?

Un'API, che sta per interfaccia di programmazione delle applicazioni, è un mezzo per chiamare un programma o un processo da un altro. Inoltre, il processo chiamato non deve nemmeno essere in esecuzione sullo stesso dispositivo del chiamato. Per quanto riguarda la parte REST, è un po' più complicata. Proviamo a spiegare.

REST, acronimo di REpresentational State Transfer, è uno stile di architettura software che delinea una serie di vincoli da utilizzare per la creazione di servizi web. Quelli che si conformano allo stile architetturale REST sono chiamati servizi web RESTful e offrono l'interoperabilità tra i sistemi informatici su Internet. Inoltre, consentono ai sistemi richiedenti di accedere e manipolare rappresentazioni testuali di varie risorse web utilizzando un insieme uniforme e predefinito di operazioni stateless.

In termini più semplici, un'API REST è facilmente accessibile utilizzando chiamate Web standard come HTTP "get", "post", "put" e "delete" e che restituiscono i dati richiesti in modo organizzato. Nel caso specifico dell'API Scrapestack , utilizza il popolare formato JSON. I risultati possono quindi essere facilmente elaborati utilizzando linguaggi comuni come Javascript. Altri strumenti possono utilizzare altri formati, con XML che è estremamente popolare. La specifica REST richiede solo l'utilizzo di un formato fisso e predefinito.

Presentazione dell'API Scrapestack

L' API Scrapestack è, devi averlo capito, un'API REST per il web scraping. In poche parole, l'API Scrapestack può trasformare qualsiasi pagina web in dati fruibili. È un servizio API basato su cloud che consente ai suoi utenti di raschiare siti Web senza doversi preoccupare di problemi tecnici come proxy, blocchi IP, targeting geografico, risoluzione di CAPTCHA e altro ancora. Per utilizzarlo, è sufficiente fornire un URL del sito Web valido e, in pochi millisecondi, l'API Scrapestack restituirà l'intero contenuto HTML del sito come risposta. Il contenuto che ottieni apparirà come visualizzato nel browser, incluso qualsiasi rendering JavaScript anziché il codice effettivo che fa parte della pagina web. Lo strumento è alimentato da uno dei motori di scraping web più potenti sul mercato e offre una delle migliori soluzioni per tutte le tue esigenze di scraping.

L' API Scrapestack è sviluppata e gestita da apilayer , una società di software con sede a Londra, Regno Unito e Vienna, Austria. È la stessa azienda che sta dietro a diversi prodotti API e SaaS popolari in tutto il mondo, inclusi weatherstack, billly ed eversign. Questa potente infrastruttura è utilizzata da più di 2000 organizzazioni in tutto il mondo. Attualmente, il servizio online, creato per elaborare milioni di indirizzi IP proxy, browser e CAPTCHA, gestisce oltre un miliardo di richieste ogni mese e vanta un'impressionante disponibilità media del 99,9%. Ciò garantisce che il servizio sarà disponibile quando ne avrai bisogno.

Un tour delle caratteristiche principali dell'API Scrapestack

Per quanto riguarda le funzionalità, l' API Scrapestack non lascia molto a desiderare, indipendentemente dal motivo per cui devi raschiare siti Web o quali dati stai cercando di ottenere, il prodotto è molto probabilmente adatto alle tue esigenze. Esploriamo brevemente alcune delle caratteristiche più importanti di questo strumento.

Milioni di proxy e indirizzi IP

Uno dei modi in cui i siti Web si proteggono dallo scraping è identificare gli indirizzi IP di origine che generano richieste multiple e successive. Per questo motivo, uno strumento di web scraping deve ricorrere all'utilizzo di indirizzi IP diversi per ogni richiesta. L' API Scrapestack risolve questo problema offrendo un ampio pool di oltre trentacinque milioni di data center e indirizzi IP proxy residenziali distribuiti su dozzine di fornitori di servizi Internet globali e supportando dispositivi reali, tentativi intelligenti e rotazione IP. Ciò garantisce che le tue richieste di scraping molto probabilmente passeranno inosservate ai siti che vengono sottoposti a scraping.

I datacenter o proxy “standard” sono i più comuni. Non sono di proprietà di alcun ISP specifico e semplicemente mascherano il tuo indirizzo IP di origine mostrando l'indirizzo IP di origine del proxy del data center e le informazioni associate alla società proprietaria del rispettivo data center.

Per quanto riguarda i proxy residenziali o "premium", forniscono indirizzi IP collegati a indirizzi residenziali reali e dispositivi domestici. Ciò rende molto meno probabile che vengano bloccati mentre raschiano il web. L'utilizzo di proxy residenziali per il web scraping semplifica l'elaborazione di contenuti geo-bloccati e la raccolta di grandi quantità di dati.

Oltre cento località globali

Alcuni siti Web restituiranno informazioni diverse in base alla posizione da cui proviene la richiesta. Allo stesso modo, alcuni siti accetteranno solo richieste da determinate località. Un esempio è un sito Web come Netflix che accetterà solo connessioni in entrata locali. È possibile accedere a Netflix statunitense solo da indirizzi IP con sede negli Stati Uniti e a Netflix canadese è possibile accedere solo da indirizzi IP canadesi. L' API Scrapestack ti consente di scegliere tra oltre cento posizioni globali supportate per inviare le tue richieste API di scraping web. Hai anche la possibilità di utilizzare geo-target casuali, supportando una serie di grandi città in tutto il mondo.

Infrastrutture solide

Un servizio basato su cloud come l' API Scrapestack è valido solo quanto l'infrastruttura su cui è costruito. A tal fine, questo è un servizio solido come una roccia con un tempo di attività impressionante. L'utilizzo del servizio ti consente di rastrellare il Web a una velocità senza precedenti. Beneficerai anche di una serie di funzionalità avanzate come richieste API simultanee, risoluzione CAPTCHA, supporto browser e rendering JS. Il servizio è costruito sull'infrastruttura cloud di apilayer . Ciò rende il servizio altamente scalabile e in grado di gestire qualsiasi cosa, da appena migliaia di richieste API al mese fino a milioni al giorno. È alimentato da un sistema che si ridimensiona in base alle esigenze e può fornire il tempo di risposta più elevato possibile per qualsiasi richiesta API a qualsiasi livello di utilizzo.

Utilizzo dell'API Scrapestack

L' utilizzo dell'API Scrapestack è semplicissimo. Il primo passo, ovviamente, è creare un account. La sua creazione rivelerà la tua chiave di accesso API univoca che devi utilizzare con ogni richiesta per autenticarti con l'API. Puoi farlo semplicemente aggiungendo il parametro access_key all'URL di base dell'API e impostandolo sulla tua chiave di accesso API.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY

I piani a pagamento supportano la crittografia HTTPS a 256 bit. Per usarlo, tutto ciò che devi fare è utilizzare HTTPS invece di HTTP nelle tue chiamate API.

Il tipo più elementare di richiesta è giustamente indicato come richiesta "di base". Nella sua forma più elementare, devi semplicemente specificare la tua chiave di accesso API e l'URL della pagina che vuoi raschiare. Ad esempio, per raschiare la pagina https://apple.com, la richiesta sarebbe simile a questa:

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com

Nota che ci sono diversi parametri facoltativi che possono essere aggiunti alle tue richieste. Discuteremo alcuni di questi in modo più dettagliato in un momento.

Dopo l'esecuzione corretta, l'API risponde con i dati HTML non elaborati dell'URL della pagina Web di destinazione. Ecco come appare una tipica risposta da una richiesta di base. Si noti che è stato abbreviato per motivi di leggibilità. Una risposta effettiva includerebbe tutto il codice all'interno del

e

sezioni.

[...] // 44 righe saltate [...] // 394 righe saltate

Parametri opzionali

Il primo e più utilizzato parametro opzionale è sicuramente il Rendering JavaScript . È disponibile su tutti i piani a pagamento. Come sai, alcune pagine web rendono gli elementi essenziali della pagina usando JavaScript. Ciò significa che alcuni contenuti non sono presenti, e quindi non recuperabili, con il caricamento iniziale della pagina. Con il parametro render_js abilitato, l' API Scrapestack accederà al Web di destinazione utilizzando un browser headless (Google Chrome) e consentirà il rendering degli elementi della pagina JavaScript prima di fornire il risultato finale dello scraping. Per abilitare questa opzione è sufficiente aggiungere il parametro render_js all'URL della richiesta API e impostarlo su 1.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & render_js = 1

Un altro utile parametro opzionale è la possibilità di specificare Proxy Locations , disponibile anche su tutti i piani a pagamento. L' API Scrapestack utilizza un pool di oltre 35 milioni di indirizzi IP in tutto il mondo. Per impostazione predefinita, ruoterà automaticamente gli indirizzi IP in modo che lo stesso indirizzo IP non venga mai utilizzato due volte di seguito. Utilizzando il parametro facoltativo proxy_location dell'API, puoi scegliere un paese specifico indicando il relativo codice paese di 2 lettere. Ad esempio, l'esempio seguente specifica au (Australia) come posizione proxy. La query verrà quindi eseguita da un indirizzo IP con sede in Australia.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & proxy_location = au

I proxy premium sono un'altra opzione interessante. Ecco come funziona. Per impostazione predefinita, l' API Scrapestack utilizza sempre proxy standard (data center) per le richieste di scraping. E sebbene siano i proxy più comuni utilizzati su Internet, è anche molto più probabile che vengano bloccati quando si tenta di raschiare i dati.

Se ti iscrivi al piano professionale o superiore, l' API Scrapestack consente l'accesso a proxy premium (residenziali). Questi sono associati a indirizzi di residenza reali e quindi è molto meno probabile che vengano bloccati durante lo scraping dei dati sul web. Come altri parametri facoltativi, l'utilizzo di questa opzione è solo questione di aggiungere il parametro premium_proxy alla tua richiesta di scraping e impostarlo su 1.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & premium_proxy = 1

Anche se potremmo andare avanti per un po' coprendo le molte opzioni disponibili con l' API Scrapestack , il nostro obiettivo è quello di recensire il prodotto, non di scrivere un manuale per esso. Inoltre, il sito Web Scrapestack ha una documentazione molto completa e dovrebbe essere la tua principale fonte di informazioni pratiche .

Informazioni sui prezzi

Il servizio API Scrapestack è disponibile con diversi piani tariffari. Al livello più basso, il piano gratuito offre un modo per familiarizzare con l'API. Ha funzionalità API di base e un limite di 10.000 richieste API al mese. Se è necessario eseguire più query o richiedere un set di funzionalità più avanzato, come richieste simultanee o accesso proxy premium, è possibile scegliere tra uno dei piani a pagamento disponibili.

Con la maggior parte dei piani a pagamento che offrono un set di funzionalità simile, il fattore decisivo quando si tratta dei tuoi requisiti tecnici sarà spesso il numero di richieste API che devi effettuare su base mensile. I pagamenti possono essere effettuati con carta di credito o PayPal. Inoltre, i clienti aziendali e ad alto volume possono richiedere l'abilitazione dei pagamenti annuali tramite bonifico bancario. E parlando di rata annuale, scegliere questa opzione dà diritto ad uno sconto del 20% rispetto alle mensilità, rendendo il prodotto ancora più conveniente. E se non sei sicuro della frequenza di fatturazione, tieni presente che puoi (relativamente) passare facilmente da mensile a annuale e viceversa. Tuttavia, comporta prima il downgrade al piano gratuito e l'aggiornamento immediato a un piano a pagamento.

Linea di fondo

Non importa quanto semplice o complessa possa essere la tua esigenza di scraping web, l' API Scrapestack può molto probabilmente aiutarti a raggiungere i tuoi obiettivi in modo semplice e senza sforzo. Con affidabilità e scalabilità impressionanti. Questo servizio basato su cloud si adatterà perfettamente a quasi tutte le situazioni. Ha tutte le opzioni di cui potresti aver bisogno e offre i mezzi per falsificare i tuoi tentativi di scraping dietro milioni di indirizzi IP proxy.

Non sei ancora sicuro che l' API Scrapestack sia adatta a te? Perché non approfittare del piano gratuito disponibile e dare al servizio una prova. Sono abbastanza sicuro che rimarrai stupito come me dalla sua utilità generale e dalle sue prestazioni.

Correggi l'errore ERR_TUNNEL_CONNECTION_FAILED in Chrome con queste soluzioni comprovate. Scopri le cause e come risolverle rapidamente.

Una cosa che adoro di Firefox e che mi dà costantemente fastidio in Chrome è il modo in cui accedo alle estensioni. In Firefox, posso cliccare

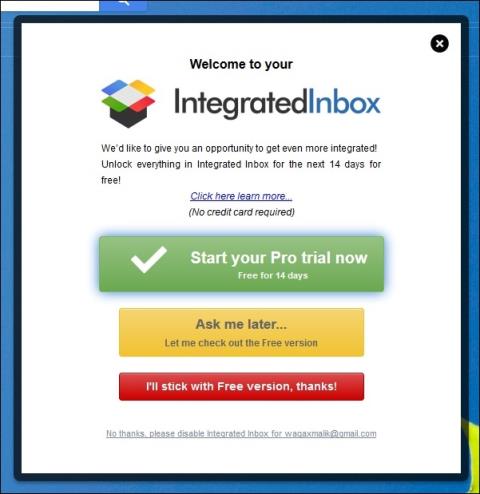

Sappiamo che tutti i servizi Google come Gmail, Calendar, Maps, Google Drive ecc. sono collettivamente etichettati come Google Apps. Il gigante della ricerca ha integrato

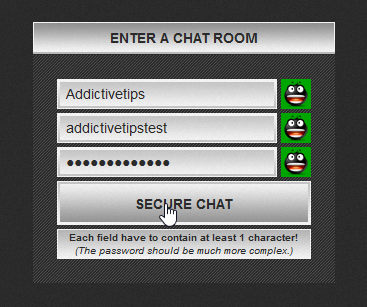

Utilizza ChatCrypt per messaggi sicuri e crittografati che mantengono private le tue conversazioni. Una piattaforma facile da usare, progettata per comunicazioni riservate, sempre e ovunque.

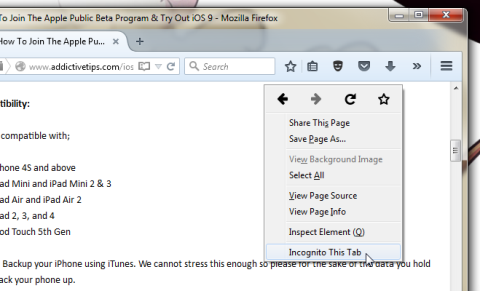

Circa due anni fa ho trovato un componente aggiuntivo per Firefox che credevo fosse un'opera di pura e semplice genialità. Il componente aggiuntivo in questione si chiama Private Tab e...

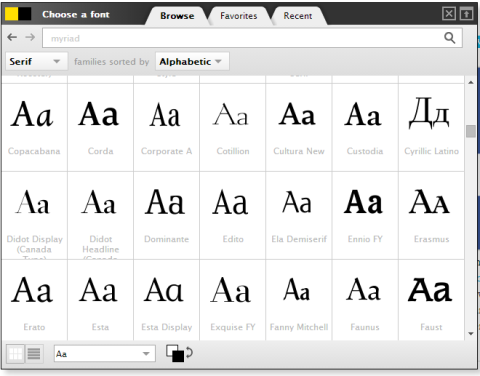

WebFonter è un'estensione di Chrome e un bookmarklet che ti consente di provare i font di FontShop, che offre un'ampia raccolta di font che puoi acquistare.

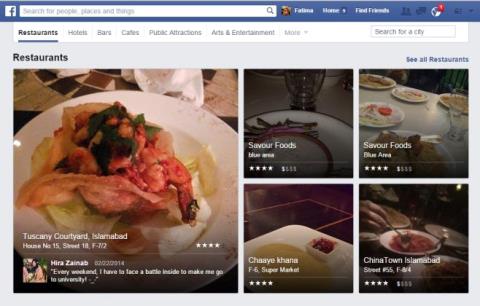

Il numero di app sviluppate per aiutare le persone a trovare cose interessanti da fare, trovare persone con cui fare cose o semplicemente trovare un buon posto dove mangiare è enorme e

Spendi soldi inutilmente comprando cose su Amazon solo per scoprire che il tuo portafoglio è vuoto quando ne hai più bisogno? Non importa quanto poco o quanto denaro spendi

Scopri come accedere e gestire le impostazioni del sito nel tuo browser. Controlla le autorizzazioni per posizione, fotocamera, microfono e altro ancora in Chrome.

Trova il miglior browser web proxy per una navigazione anonima, una sicurezza avanzata e una gestione proxy fluida. Esplora subito le migliori opzioni!

![Agora ti consente di confrontare i prodotti quando acquisti articoli online [Chrome] Agora ti consente di confrontare i prodotti quando acquisti articoli online [Chrome]](https://tips.webtech360.com/resources8/r252/image-5055-0829094639067.jpg)