Alle Fixes für den Fehler ERR_TUNNEL_CONNECTION_FAILED

Beheben Sie den Fehler ERR_TUNNEL_CONNECTION_FAILED in Chrome mit diesen bewährten Lösungen. Erfahren Sie die Ursachen und wie Sie sie schnell beheben können.

Web-Scraping mag einfach aussehen, kann sich jedoch als ziemlich komplexes Unterfangen herausstellen. Viele Website-Besitzer versuchen, sich aktiv dagegen zu schützen, um ihre Daten zu schützen, was meist verhindert, dass ein internes Skript ausgeführt wird, um wiederholt Daten von Ziel-Websites abzurufen. Für ein effizientes Scraping benötigen Sie ein spezielles Tool wie die Scrapestack-API , die wir gleich überprüfen werden. Damit können Sie fast jede Website schnell und effizient durchsuchen und die darin enthaltenen Informationen extrahieren und sinnvoll nutzen. Scrapestack bietet eine schnelle und einfach zu verwendende und hochgradig skalierbare Möglichkeit zum Scrapen von Websites.

Bevor wir näher auf die Scrapestack-API eingehen, diskutieren wir zunächst das Scraping. Wir erklären, was es ist und warum es im Internet so weit verbreitet ist. Und wenn wir über das Internet sprechen, werden wir uns dann den speziellen Fall des Web-Scrapings ansehen, denn dafür ist die Scrapestack-API gemacht und wir stellen auch einige der wichtigsten Gründe vor, warum jemand einen Drittanbieter verwenden würde Scraping-API wie diese. Nachdem wir kurz erklärt haben, was eine REST-API ist, kommen wir endlich zum Kern der Sache und präsentieren die Scrapestack-API. Wir werden uns zuerst einen Überblick über das Produkt verschaffen, bevor wir einige seiner besten Funktionen weiter analysieren. Im Folgenden sehen wir uns an, wie einfach die Verwendung der API ist, bevor wir die mehrstufige Preisstruktur des Dienstes vorstellen.

Schaben in Kürze

Data Scraping ist der Prozess des Extrahierens von Daten aus einer für Menschen lesbaren Ausgabe, die von einem anderen Programm oder Prozess stammt. Sie unterscheidet sich in vielerlei Hinsicht von anderen Formen der Datenübertragung. Die Datenübertragung zwischen Programmen erfolgt normalerweise unter Verwendung von Datenstrukturen, die für die automatisierte Verarbeitung durch Computer geeignet sind. Diese Austauschformate und Protokolle sind fest strukturiert, gut dokumentiert, leicht zu analysieren und halten Mehrdeutigkeiten auf ein Minimum. Diese Übertragungen sind normalerweise überhaupt nicht für Menschen lesbar. Sie sind auf Effizienz und Schnelligkeit ausgelegt. Das Hauptelement, das das Daten-Scraping von anderen Formen des Datenaustauschs unterscheidet, besteht darin, dass die Ausgabe, die gescrapt wird, normalerweise dazu bestimmt ist, einem Endbenutzer angezeigt zu werden, und nicht als Eingabe für ein anderes Programm. Als solches wird es daher selten dokumentiert oder für eine bequeme Analyse strukturiert.

Es gibt einige Gründe, warum man auf Data Scraping zurückgreifen würde. Zum Beispiel wird es am häufigsten gemacht, um entweder eine Schnittstelle zu einem Altsystem herzustellen, das keinen anderen Mechanismus hat, der mit aktuellen Übertragungsmechanismen kompatibel ist. Es könnte auch verwendet werden, um Daten von einem Drittsystem abzurufen, das keine bequemere API bietet. Im letzteren Fall kann der Besitzer des Drittsystems das Daten-Scraping aus Gründen wie erhöhter Systemlast, Verlust von Werbeeinnahmen oder Kontrollverlust über den Informationsinhalt als unerwünscht ansehen.

So weit verbreitet es auch geworden ist, wird Data Scraping normalerweise als ad hoc, unelegante Technik betrachtet, die oft als letztes Mittel verwendet wird, wenn kein anderer Mechanismus für den Datenaustausch verfügbar ist. Data Scraping ist oft mit einem höheren Programmier- und Verarbeitungsaufwand verbunden, da Ausgabedisplays, die für den menschlichen Gebrauch bestimmt sind, häufig ihre Struktur ändern. Während sich Menschen leicht an diese Veränderungen anpassen können, kann ein Computerprogramm möglicherweise nicht, da es angewiesen wurde, Daten in einem bestimmten Format oder von einem bestimmten Ort zu lesen, ohne zu wissen, wie die Ergebnisse auf Gültigkeit überprüft werden.

Der spezielle Fall von Web Scraping

Web-Scraping ist einfach eine bestimmte Art von Daten-Scraping, die verwendet wird, um Daten von Webseiten abzurufen. Wie Sie wissen, werden Webseiten mit textbasierten Auszeichnungssprachen wie HTML und XHTML erstellt. Sie sind jedoch in der Regel für menschliche Endbenutzer und nicht für eine einfache automatisierte Verwendung ausgelegt. Dies ist der Hauptgrund, warum Web-Scraper wie die Scrapestack-API erstellt wurden. Ein Web Scraper ist eine API oder ein Tool, das Daten aus einer Website extrahiert.

Da Unternehmen ihre Daten in der Regel sehr schützen, verwenden große Websites normalerweise Abwehralgorithmen, um sie vor Web-Scrapern zu schützen. Sie können beispielsweise die Anzahl der Anfragen begrenzen, die ein IP oder ein IP-Netzwerk senden darf. Die besten Web-Scraping-Tools enthalten Mechanismen, um diesen Schutzmaßnahmen entgegenzuwirken.

Verwenden einer Scraping-API eines Drittanbieters

Web-Scraping von einer einfachen, statischen Webseite ist in der Regel recht einfach zu implementieren. Leider gehören einfache, statische Webseiten der fernen Vergangenheit an und die meisten modernen Webseiten greifen auf verschiedene Technologien zurück, um ihren Besuchern dynamische Inhalte bereitzustellen. Hier kann der Einsatz eines Drittanbieter-Tools von Vorteil sein. Diese Tools verarbeiten alle zugrunde liegenden Details und erscheinen auf der Website, die sie als normaler Benutzer suchen. Einige gehen sogar so weit, Formulare für Sie auszufüllen. Aber der beste Grund, warum jemand ein Scraping-Tool von Drittanbietern wie die Scrapestack-API verwenden würde, ist die Bequemlichkeit. Die Verwendung macht die Dinge einfach viel einfacher.

Was ist eine REST-API?

Eine API, die für Application Programming Interface steht, ist ein Mittel, um ein Programm oder einen Prozess von einem anderen aus aufzurufen. Außerdem muss der angerufene Prozess nicht einmal auf demselben Gerät wie der Angerufene laufen. Der REST-Teil ist etwas komplizierter. Versuchen wir es zu erklären.

REST steht für REpresentational State Transfer und ist ein Softwarearchitekturstil, der eine Reihe von Einschränkungen für die Erstellung von Webservices umreißt. Jene, die dem REST-Architekturstil entsprechen, werden als RESTful-Webdienste bezeichnet und bieten Interoperabilität zwischen Computersystemen im Internet. Darüber hinaus ermöglichen sie den anfordernden Systemen, auf Textdarstellungen verschiedener Webressourcen zuzugreifen und diese zu manipulieren, indem sie einen einheitlichen und vordefinierten Satz zustandsloser Operationen verwenden.

Einfacher ausgedrückt ist eine REST-API eine, auf die über Standard-Webaufrufe wie HTTP „get“, „post“, „put“ und „delete“ leicht zugegriffen werden kann und die die angeforderten Daten in organisierter Weise zurückgeben. Im speziellen Fall der Scrapestack API verwendet sie das beliebte JSON-Format. Ergebnisse können daher problemlos mit gängigen Sprachen wie Javascript verarbeitet werden. Andere Tools können andere Formate verwenden, wobei XML sehr beliebt ist. Die REST-Spezifikation schreibt lediglich vor, dass ein festes, vordefiniertes Format verwendet wird.

Einführung in die Scrapestack-API

Die Scrapestack API ist eine REST-API für Web-Scraping. Kurz gesagt, die Scrapestack API kann jede Webseite in umsetzbare Daten umwandeln. Es ist ein Cloud-basierter API-Dienst, der es seinen Benutzern ermöglicht, Websites zu durchsuchen, ohne sich um technische Probleme wie Proxys, IP-Blöcke, Geo-Targeting, CAPTCHA-Lösung und mehr kümmern zu müssen. Um es zu verwenden, geben Sie ihm einfach eine gültige Website-URL und innerhalb weniger Millisekunden gibt die Scrapestack-API den vollständigen HTML-Inhalt der Website als Antwort zurück. Der Inhalt, den Sie erhalten, wird so angezeigt, wie er im Browser angezeigt wird, einschließlich des JavaScript-Renderings und nicht des eigentlichen Codes, der Teil der Webseite ist. Das Tool wird von einer der leistungsstärksten Web-Scraping-Engines auf dem Markt angetrieben und bietet eine der besten Lösungen für alle Ihre Scraping-Anforderungen.

Die Scrapestack API wird von apilayer entwickelt und gewartet , einem Softwareunternehmen mit Sitz in London, Großbritannien und Wien, Österreich. Es ist dasselbe Unternehmen, das weltweit hinter mehreren beliebten API- und SaaS-Produkten steht, darunter Weatherstack, Invoice und Eversign. Diese leistungsstarke Infrastruktur wird von mehr als 2000 Organisationen weltweit genutzt. Derzeit verarbeitet der Onlinedienst, der Millionen von Proxy-IP-Adressen, Browsern und CAPTCHAs verarbeitet, jeden Monat über eine Milliarde Anfragen und bietet eine beeindruckende durchschnittliche Betriebszeit von 99,9 %. Dadurch wird sichergestellt, dass der Dienst verfügbar ist, wenn Sie ihn benötigen.

Eine Tour durch die Hauptfunktionen der Scrapestack-API

In Bezug auf die Funktionen lässt die Scrapestack-API nicht viel zu wünschen übrig, egal warum Sie Websites scratchen müssen oder welche Daten Sie abrufen möchten , das Produkt ist höchstwahrscheinlich die beste Lösung für Ihre Anforderungen. Lassen Sie uns kurz einige der wichtigsten Funktionen dieses Tools untersuchen.

Millionen von Proxys und IP-Adressen

Eine der Möglichkeiten, wie Websites sich gegen Scraping schützen, besteht darin, Quell-IP-Adressen zu identifizieren, die mehrere aufeinanderfolgende Anfragen generieren. Aus diesem Grund muss ein Web-Scraping-Tool für jede Anfrage auf unterschiedliche IP-Adressen zurückgreifen. Die Scrapestack API adressiert dies, indem sie einen umfangreichen Pool von über 35 Millionen Rechenzentrums- und Wohn-Proxy-IP-Adressen bietet, die über Dutzende von globalen Internetdienstanbietern verteilt sind, sowie durch die Unterstützung echter Geräte, intelligenter Wiederholungen und IP-Rotation. Dadurch wird sichergestellt, dass Ihre Scraping-Anfragen höchstwahrscheinlich unbemerkt an die Websites gelangen, die gescrapt werden.

Die Rechenzentrums- oder „Standard“-Proxys sind die gebräuchlichsten. Sie gehören keinem bestimmten ISP und maskieren einfach Ihre Ursprungs-IP-Adresse, indem sie die Quell-IP-Adresse des Datencenter-Proxys und die Informationen anzeigen, die mit dem Unternehmen verbunden sind, dem das jeweilige Datencenter gehört.

Die Wohn- oder „Premium“-Proxys stellen IP-Adressen bereit, die mit echten Wohnadressen und Heimgeräten verbunden sind. Dies macht es viel weniger wahrscheinlich, dass sie beim Scrapen des Webs blockiert werden. Die Verwendung von Privat-Proxys für das Web-Scraping macht es einfach, geografisch gesperrte Inhalte zu umgehen und große Datenmengen zu sammeln.

Über hundert Standorte weltweit

Einige Websites geben basierend auf dem Standort, von dem die Anfrage stammt, unterschiedliche Informationen zurück. Ebenso akzeptieren einige Websites nur Anfragen von bestimmten Standorten. Ein solches Beispiel ist eine Website wie Netflix, die nur lokale eingehende Verbindungen akzeptiert. Auf das US-Netflix kann nur von US-basierten IP-Adressen zugegriffen werden und das kanadische Netflix kann nur von kanadischen IP-Adressen aus erreicht werden. Mit der Scrapestack-API können Sie aus über hundert unterstützten globalen Standorten auswählen, um Ihre Web-Scraping-API-Anfragen zu senden. Sie haben auch die Möglichkeit, zufällige Geoziele zu verwenden, die eine Reihe von Großstädten weltweit unterstützen.

Solide Infrastruktur

Ein Cloud-basierter Dienst wie die Scrapestack API ist nur so gut wie die Infrastruktur, auf der er aufbaut . In diesem Sinne ist dies ein grundsolider Service mit einer beeindruckenden Betriebszeit. Mit dem Dienst können Sie das Web mit beispielloser Geschwindigkeit durchsuchen. Sie profitieren auch von einer Vielzahl fortschrittlicher Funktionen wie gleichzeitige API-Anfragen, CAPTCHA-Lösung, Browserunterstützung und JS-Rendering. Der Dienst baut auf der apilayer- Cloud-Infrastruktur auf. Dies macht den Dienst hoch skalierbar und kann alles von nur Tausenden von API-Anfragen pro Monat bis hin zu Millionen pro Tag verarbeiten. Es wird von einem System betrieben, das nach Bedarf hoch- und herunterskaliert und die höchstmögliche Antwortzeit für jede API-Anfrage bei jedem Auslastungsgrad bietet.

Verwenden der Scrapestack-API

Die Verwendung der Scrapestack-API ist so einfach wie möglich. Der erste Schritt besteht natürlich darin, ein Konto zu erstellen. Wenn Sie ihn erstellen, wird Ihr eindeutiger API-Zugriffsschlüssel angezeigt, den Sie bei jeder Anfrage verwenden müssen, um sich bei der API zu authentifizieren. Dazu fügen Sie einfach den Parameter access_key an die Basis-URL der API an und legen ihn auf Ihren API-Zugriffsschlüssel fest.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY

Die kostenpflichtigen Pläne unterstützen die 256-Bit-HTTPS-Verschlüsselung. Um es zu verwenden, müssen Sie in Ihren API-Aufrufen nur HTTPS anstelle von HTTP verwenden.

Die einfachste Art von Anfrage wird treffend als „einfache“ Anfrage bezeichnet. In seiner einfachsten Form müssen Sie lediglich Ihren API-Zugriffsschlüssel und die URL der Seite angeben, die gescrapt werden soll. Um beispielsweise die Seite https://apple.com abzukratzen, würde die Anfrage so aussehen:

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & URL = https://apple.com

Beachten Sie, dass Ihren Anforderungen mehrere optionale Parameter hinzugefügt werden können. Auf einige davon werden wir gleich näher eingehen.

Nach erfolgreicher Ausführung antwortet die API mit den HTML-Rohdaten Ihrer Zielwebseiten-URL. So sieht eine typische Antwort auf eine einfache Anfrage aus. Beachten Sie, dass es aus Gründen der Lesbarkeit gekürzt wurde. Eine tatsächliche Antwort würde den gesamten Code innerhalb der

und

Abschnitte.

[...] // 44 Zeilen übersprungen [...] // 394 Zeilen übersprungen

Optionale Parameter

Der erste und am häufigsten verwendete optionale Parameter ist sicherlich das JavaScript Rendering . Es ist für alle kostenpflichtigen Pläne verfügbar. Wie Sie wissen, rendern einige Webseiten wesentliche Seitenelemente mit JavaScript. Dies bedeutet, dass einige Inhalte beim anfänglichen Laden der Seite nicht vorhanden sind und daher nicht kopiert werden können. Wenn der Parameter render_js aktiviert ist, greift die Scrapestack-API über einen Headless-Browser (Google Chrome) auf das Zielweb zu und ermöglicht das Rendern von JavaScript-Seitenelementen, bevor das endgültige Scraping-Ergebnis geliefert wird. Um diese Option zu aktivieren, müssen Sie einfach den Parameter render_js an Ihre API-Anforderungs-URL anhängen und auf 1 setzen.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & render_js = 1

Ein weiterer nützlicher optionaler Parameter ist die Möglichkeit, Proxy-Standorte anzugeben , die auch bei allen kostenpflichtigen Plänen verfügbar ist. Die Scrapestack API verwendet einen Pool von über 35 Millionen IP-Adressen weltweit. Standardmäßig werden IP-Adressen automatisch so rotiert, dass dieselbe IP-Adresse nie zweimal hintereinander verwendet wird. Mit dem optionalen Parameter proxy_location der API können Sie ein bestimmtes Land auswählen, indem Sie seinen aus zwei Buchstaben bestehenden Ländercode angeben. Das folgende Beispiel gibt beispielsweise au (Australien) als Proxy-Standort an. Die Abfrage wird somit von einer in Australien ansässigen IP-Adresse ausgeführt.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & proxy_location = au

Die Premium-Proxys sind eine weitere interessante Option. So funktioniert das. Standardmäßig verwendet die Scrapestack-API immer Standard-Proxys (Rechenzentrum) zum Scraping-Anfragen. Und obwohl sie die am häufigsten im Internet verwendeten Proxys sind, werden sie beim Versuch, Daten zu sammeln, viel häufiger blockiert.

Wenn Sie den Professional-Plan oder höher abonnieren, ermöglicht die Scrapestack-API den Zugriff auf Premium-Proxys ( Wohnzimmer ). Diese sind mit echten Wohnadressen verbunden und werden daher viel weniger wahrscheinlich beim Scrapen von Daten im Internet blockiert. Wie bei anderen optionalen Parametern müssen Sie bei dieser Option nur den premium_proxy-Parameter an Ihre Scraping-Anfrage anhängen und auf 1 setzen.

https://api.scrapestack.com/scrape ? access_key = YOUR_ACCESS_KEY & url = https://apple.com & premium_proxy = 1

Wir könnten zwar noch eine ganze Weile die vielen Optionen der Scrapestack-API behandeln , aber unser Ziel ist es, das Produkt zu überprüfen und kein Handbuch dafür zu schreiben. Außerdem verfügt die Scrapestack- Website über eine sehr gründliche Dokumentation und sollte Ihre Hauptquelle für Anleitungen sein .

Preisinformationen

Der Scrapestack-API- Dienst ist unter mehreren Preisplänen verfügbar. Auf der untersten Ebene bietet der Free Plan eine Möglichkeit, sich mit der API vertraut zu machen. Es verfügt über grundlegende API-Funktionen und eine Begrenzung von 10 000 API-Anfragen pro Monat. Wenn Sie mehr Abfragen ausführen müssen oder erweiterte Funktionen benötigen, z. B. gleichzeitige Anforderungen oder Premium-Proxy-Zugriff, können Sie einen der verfügbaren kostenpflichtigen Pläne auswählen.

Da die meisten kostenpflichtigen Tarife einen ähnlichen Funktionsumfang bieten, ist die Anzahl der monatlich zu stellenden API-Anfragen der entscheidende Faktor für Ihre technischen Anforderungen. Zahlungen können per Kreditkarte oder PayPal erfolgen. Darüber hinaus können Unternehmens- und Großkunden die Aktivierung jährlicher Banküberweisungen verlangen. Apropos jährliche Zahlung: Wenn Sie diese Option wählen, erhalten Sie 20 % Rabatt im Vergleich zu den monatlichen Zahlungen, wodurch das Produkt noch erschwinglicher wird. Und wenn Sie sich bei der Abrechnungshäufigkeit nicht sicher sind, beachten Sie, dass Sie (relativ) einfach von monatlich auf jährlich und zurück wechseln können. Es beinhaltet jedoch zuerst ein Downgrade auf den kostenlosen Plan und ein sofortiges Upgrade auf einen kostenpflichtigen Plan.

Endeffekt

Egal wie einfach oder komplex Ihre Web-Scraping-Anforderungen auch sein mögen, die Scrapestack-API kann Ihnen höchstwahrscheinlich dabei helfen, Ihre Ziele einfach und mühelos zu erreichen. Mit beeindruckender Zuverlässigkeit und Skalierbarkeit. Dieser Cloud-basierte Dienst passt sich nahezu jeder Situation perfekt an. Es bietet alle Optionen, die Sie benötigen könnten, und bietet die Möglichkeit, Ihre Scraping-Versuche hinter Millionen von Proxy-IP-Adressen zu fälschen.

Sie sind sich noch nicht sicher, ob die Scrapestack API das Richtige für Sie ist? Warum nutzen Sie nicht den verfügbaren kostenlosen Plan und testen den Dienst. Ich bin mir ziemlich sicher, dass Sie von seiner allgemeinen Nützlichkeit und Leistung genauso überrascht sein werden wie ich.

Beheben Sie den Fehler ERR_TUNNEL_CONNECTION_FAILED in Chrome mit diesen bewährten Lösungen. Erfahren Sie die Ursachen und wie Sie sie schnell beheben können.

Was ich an Firefox absolut liebe und was mich bei Chrome ständig ärgert, ist der Zugriff auf die Erweiterungen. In Firefox kann ich

Wir wissen, dass alle Google-Dienste wie Gmail, Kalender, Maps, Google Drive usw. zusammen als Google Apps bezeichnet werden. Der Suchgigant hat

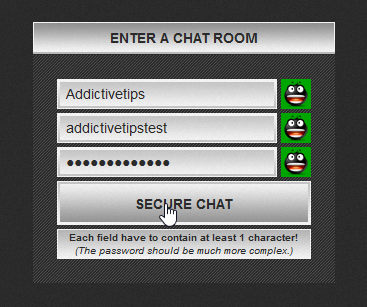

Verwenden Sie ChatCrypt für sicheres, verschlüsseltes Messaging, das Ihre Unterhaltungen vertraulich hält. Benutzerfreundliche Plattform für vertrauliche Kommunikation jederzeit und überall.

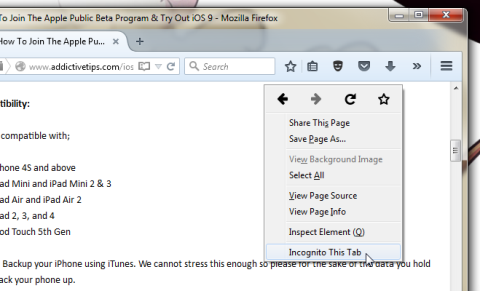

Vor gut zwei Jahren fand ich ein Firefox-Add-on, das ich für ein schlichtes und doch geniales Werk hielt. Das Add-on heißt Private Tab und es

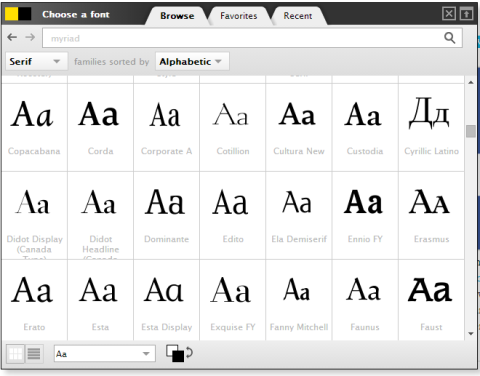

WebFonter ist eine Chrome-Erweiterung und ein Bookmarklet, mit dem Sie Schriftarten aus dem FontShop ausprobieren können, der eine große Sammlung käuflicher Schriftarten bietet.

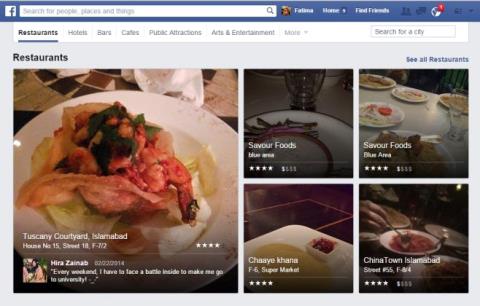

Die Anzahl der Apps, die entwickelt wurden, um Menschen dabei zu helfen, interessante Dinge zu tun, Leute zu finden, mit denen sie etwas unternehmen können, oder einfach nur ein gutes Restaurant zu finden, ist riesig und

Geben Sie unnötig Geld für den Kauf von Sachen bei Amazon aus, nur um dann festzustellen, dass Ihr Geldbeutel leer ist, wenn Sie ihn am meisten brauchen? Egal, wie wenig oder wie viel Geld Sie

Erfahren Sie, wie Sie in Ihrem Browser auf Website-Einstellungen zugreifen und diese verwalten. Steuern Sie die Berechtigungen für Standort, Kamera, Mikrofon und mehr in Chrome.

Finden Sie den besten Proxy-Webbrowser für anonymes Surfen, verbesserte Sicherheit und nahtlose Proxy-Verwaltung. Entdecken Sie jetzt die besten Optionen!

![Mit Agora können Sie Produkte vergleichen, wenn Sie Artikel online kaufen [Chrome] Mit Agora können Sie Produkte vergleichen, wenn Sie Artikel online kaufen [Chrome]](https://tips.webtech360.com/resources8/r252/image-5055-0829094639067.jpg)